超长上下文与多模态交互类应用显著推升KV Cache存储需求,AI工作负载对高带宽、大容量SSD的需求将持续增强,AI服务器本地、AI推理用SSD市场空间将进一步扩大。建议关注产业链核心受益标的。

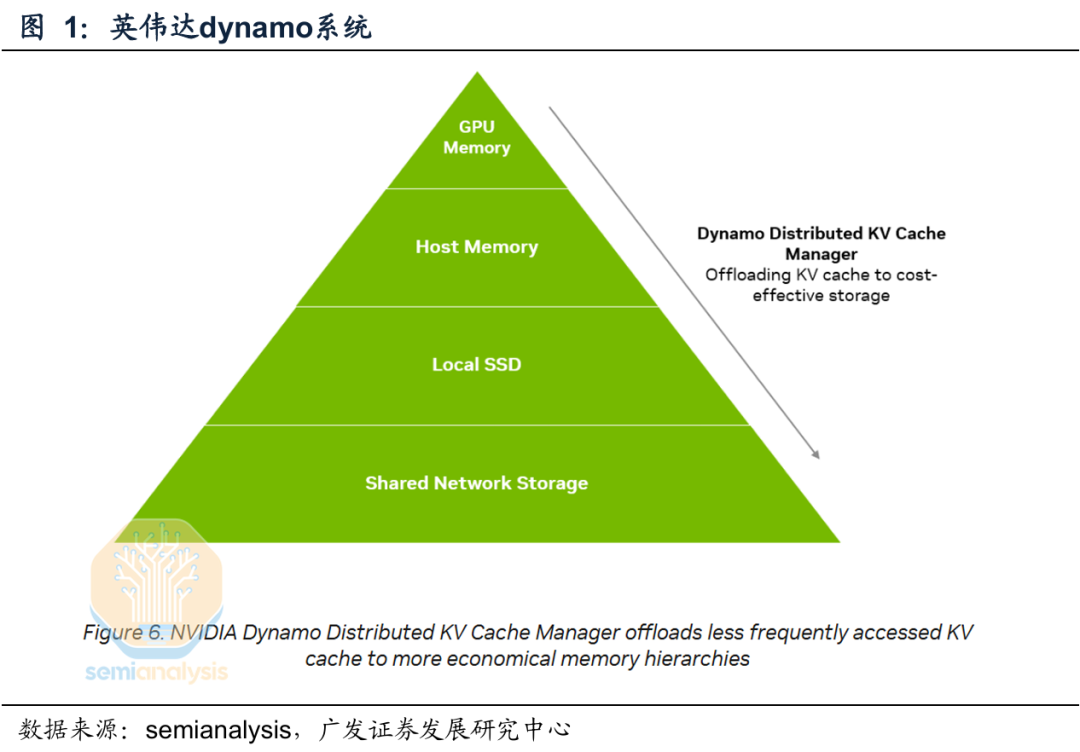

英伟达推出AI推理上下文存储平台。英伟达在2026 CES正式发布推理上下文内存存储平台(NVIDIA Context Memory Storage Platform)。AI工作负载正从传统的短上下文、单轮交互模式,全面转向长上下文、多轮对话以及多智能体(Agentic AI)协同执行的复杂场景。该平台基于BlueField-4与Spectrum-X Ethernet加速,与NVIDIA Dynamo和NVLink紧密耦合,实现内存、存储、网络之间的协同上下文调度,该平台将上下文作为一等数据类型处理,可实现5倍的推理性能、5倍的更优能效。具体来看,每个存储tray搭配4个BlueField-4 DPU,每个BlueField-4 DPU管理150TB上下文内存空间,通过这种设计,每块GPU将额外获得16TB的上下文内存支持,带宽为200Gbps。

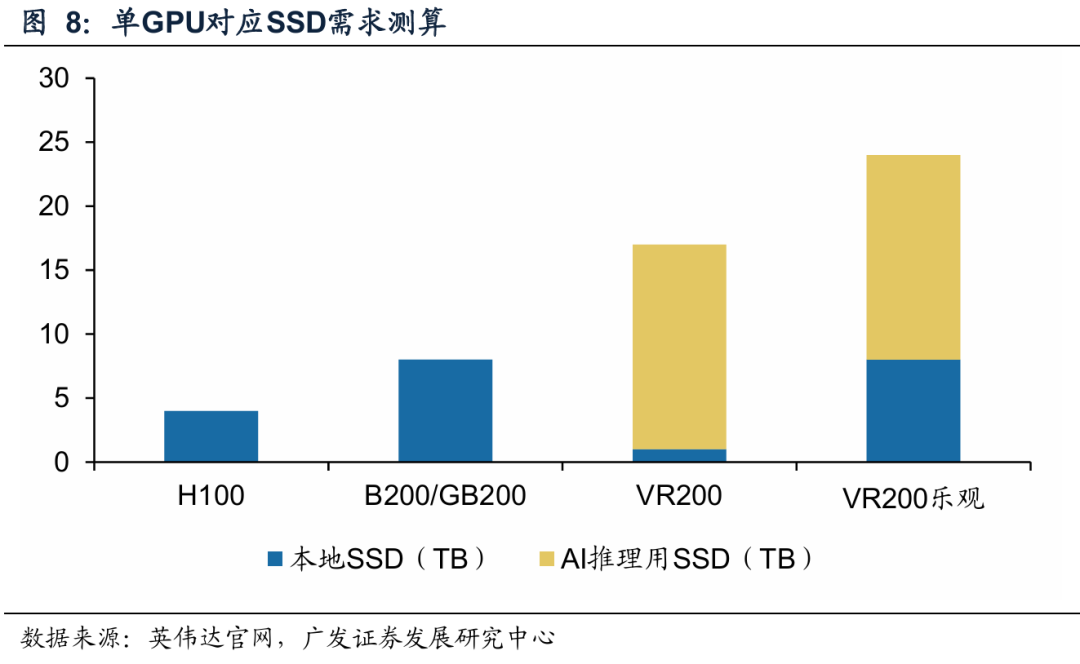

单个GPU对应的eSSD容量增长显著。根据我们外发的报告《AI的进击时刻21:AI&存储服务器用eSSD空间广阔》,根据Nvidia NVL72 by HPE白皮书,每个计算tray的缓存盘总容量为30TB(由8块3.84TB NVMe SSD组成),操作系统盘为1块1.92TB NVMe SSD,即单GPU对应2个本地SSD卡槽。我们假设单GPU对应2个本地SSD卡槽;单卡槽对应的eSSD容量为4TB。根据我们测算,H100对应的eSSD需求为4TB,B100/200对应的eSSD需求为8TB,乐观情况下,Rubin对应的eSSD需求为24TB,AI服务器本地、AI推理SSD需求将进一步扩大。

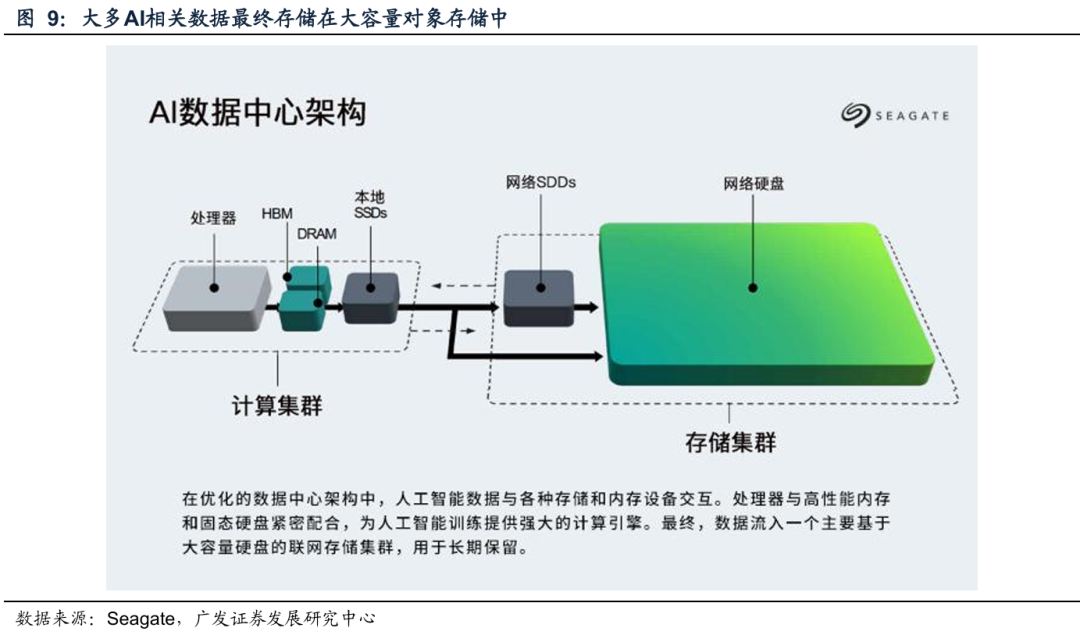

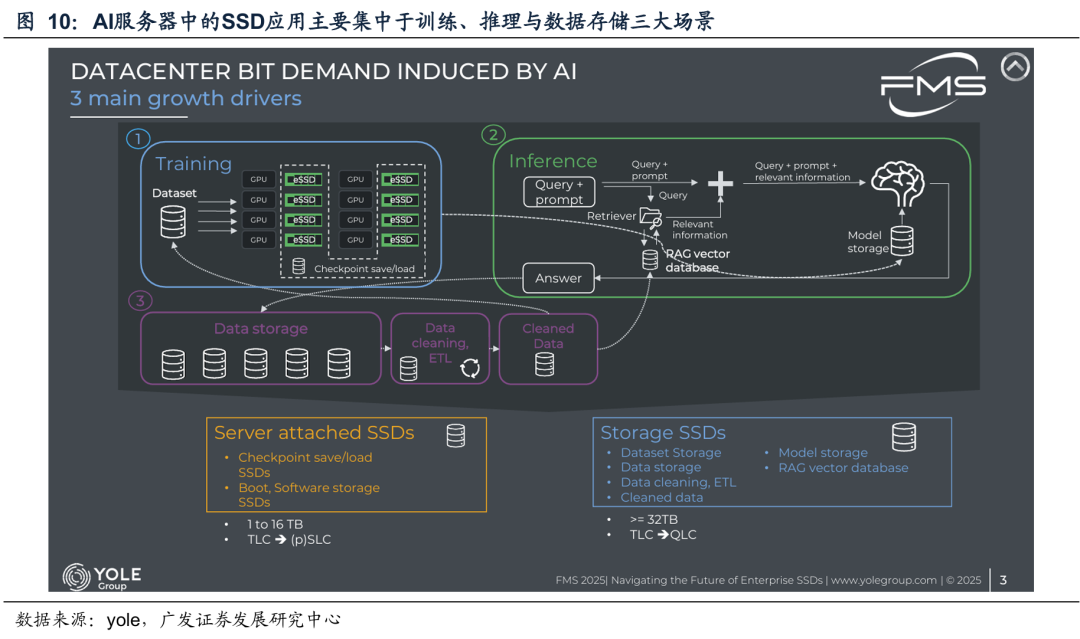

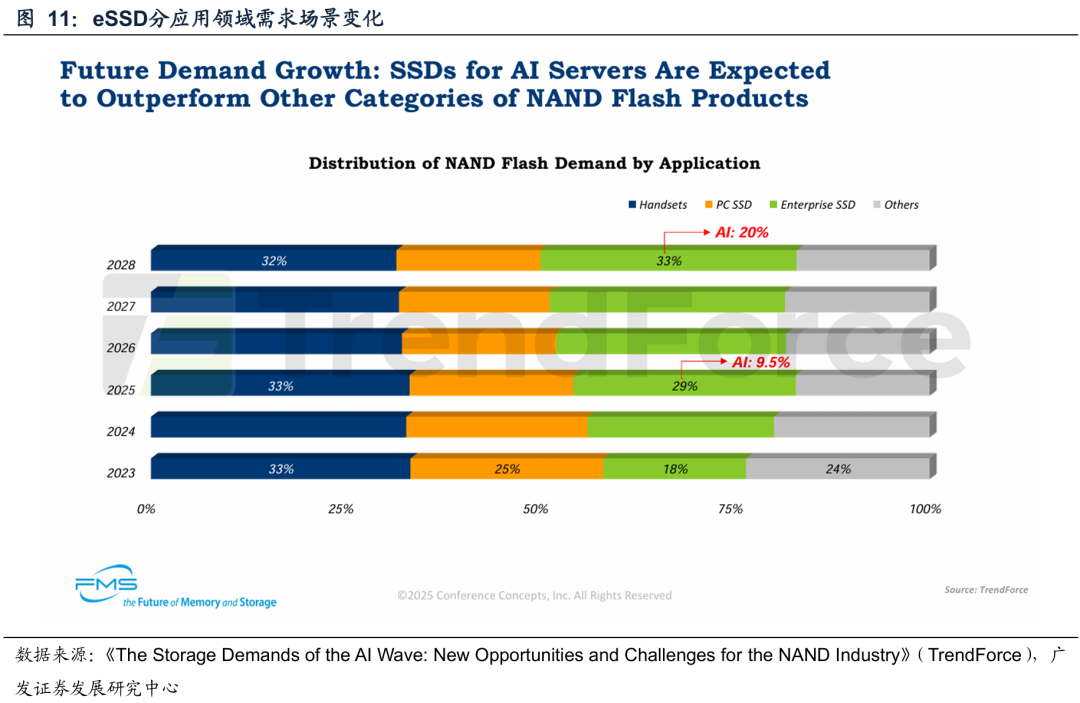

AI推理与数据存储构成SSD核心增量需求。根据TrendForce报告,2025年SSD下游应用来看,手机用SSD需求占比为33%,企业级用SSD需求占比为29%,其中AI用SSD需求占比为10%;2028年,手机用SSD需求占比为32%,企业级用SSD需求占比将提升至33%,其中AI用SSD需求占比将提升至20%。在AI应用体系中SSD主要用于训练、推理及数据存储,其中AI推理与数据存储构成SSD核心增量需求场景。在推理阶段,长上下文产生的KV Cache 以HBM/DRAM为首选热存储,超过内存容量的热数据会外溢至高性能eSSD承接;此外,RAG数据库用于大规模知识检索与上下文扩展,亦依赖SSD 提供大容量与高吞吐支持。在数据存储阶段,SSD用于tokens的保存、数据清洗与ETL流程。随着长上下文推理、RAG数据库及tokens规模的快速增长,AI服务器本地、AI推理、网络存储用SSD市场空间将进一步扩大。

投资建议。超长上下文与多模态交互类应用显著推升KV Cache存储需求,AI工作负载对高带宽、大容量SSD的需求将持续增强,AI服务器本地、AI推理用SSD市场空间将进一步扩大。建议关注产业链核心受益标的。

风险提示

AI产业发展以及需求不及预期;AI服务器出货量不及预期,国产厂商技术和产品进展不及预期。

一、AI推理上下文存储平台利好eSSD

二、AI推理与数据存储构成eSSD核心增量需求场景

三、投资建议

超长上下文与多模态交互推理显著推升KV Cache存储需求,AI工作负载对高带宽、大容量SSD的需求将持续增强,AI服务器本地、AI推理用SSD市场空间将进一步扩大。建议关注产业链核心受益标的。

风险提示

(一)AI产业发展以及需求不及预期

若AI相关模型和应用发展或下游需求发展不如预期,使得产业发展不如预期,进而影响AI服务器需求。

(二)AI服务器出货量不及预期

AI服务器出货量一方面受到企业IT支出,尤其是云计算厂商的Capex支出影响,因此若企业对算力设施的投入不及预期,可能影响AI服务器的出货量;另一方面AI服务器价值量占比较高的GPU和CPU若出现供应紧张等问题,也会对AI服务器的出货量级和节奏造成一定消极影响。

(三)国产厂商技术和产品进展不及预期

目前国内厂商不断开发模型以及相关应用,若在算力、数据、算法等某一因素上支撑不及预期,则可能导致国内厂商技术和产品进展不及预期。

VIP复盘网

VIP复盘网