本周美国官宣,将允许英伟达向中国出售H200人工智能芯片。全球最先进的算力卡,重新进入中国市场,这必然会推动国内大厂商,加速算力基建的投资。

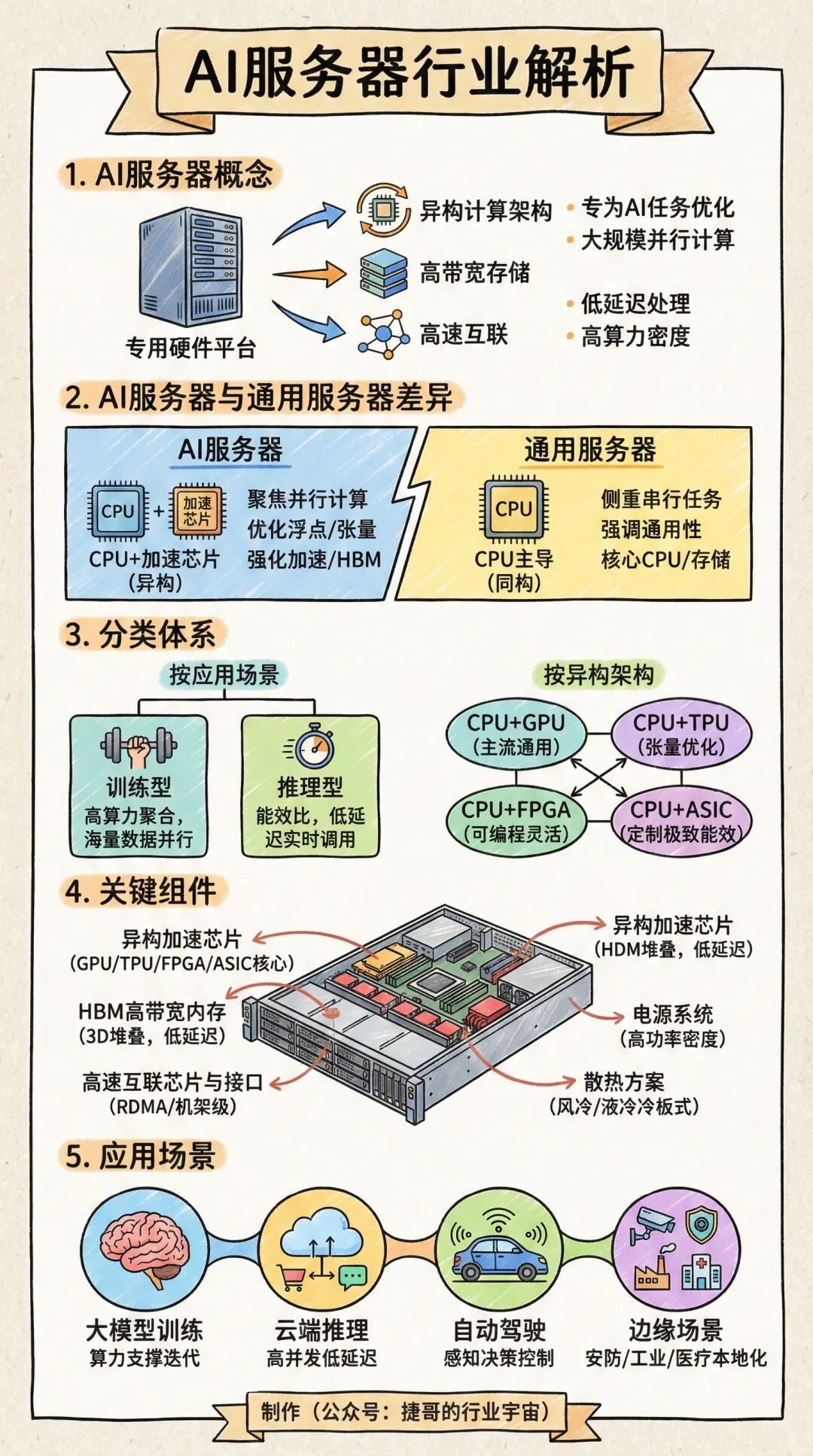

AI服务器是为深度学习训练、大模型推理等密集型计算任务设计的专用设备。与传统服务器的不同,主要围绕异构计算架构设计,以高算力芯片为核心实现算力输出。

今天重点梳理 AI服务器 。

AI服务器介绍

AI服务器的概念

AI服务器,是基于异构计算架构构建的专用硬件平台,通过集成专用加速芯片、高带宽存储及高速互联组件,专为人工智能任务优化设计,具备大规模并行计算、低延迟数据处理及高算力密度等核心特性。

AI服务器与通用服务器的差异

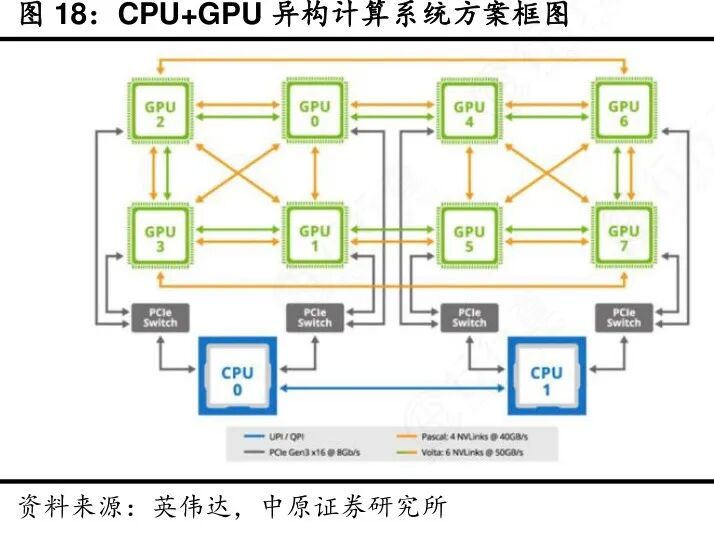

架构设计方面,AI服务器采用“CPU 专用加速芯片”异构架构,聚焦并行计算优化;通用服务器以CPU为主导的同构架构,侧重串行任务处理。

性能优化方面,AI服务器针对浮点运算、张量计算进行专项优化,支持混合精度计算;通用服务器强调CPU通用性与多任务调度灵活性。

硬件配置方面,AI服务器强化加速芯片、高带宽内存及高速互联组件;通用服务器以CPU性能、存储容量及兼容性为核心配置方向。

AI服务器分类体系

1)按应用场景分类

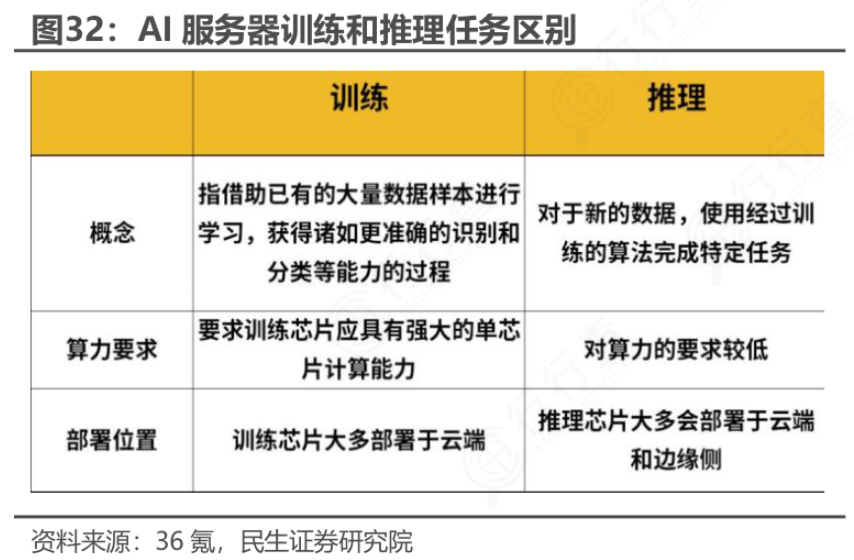

训练型AI服务器:是面向大规模AI模型训练任务,核心特征为高算力聚合能力与扩展性能,支持海量数据并行处理与复杂模型参数运算。

推理型AI服务器:针对模型部署后的实时响应场景设计,以能效比与低延迟为核心优化目标,适配各类终端应用的实时算力调用需求。

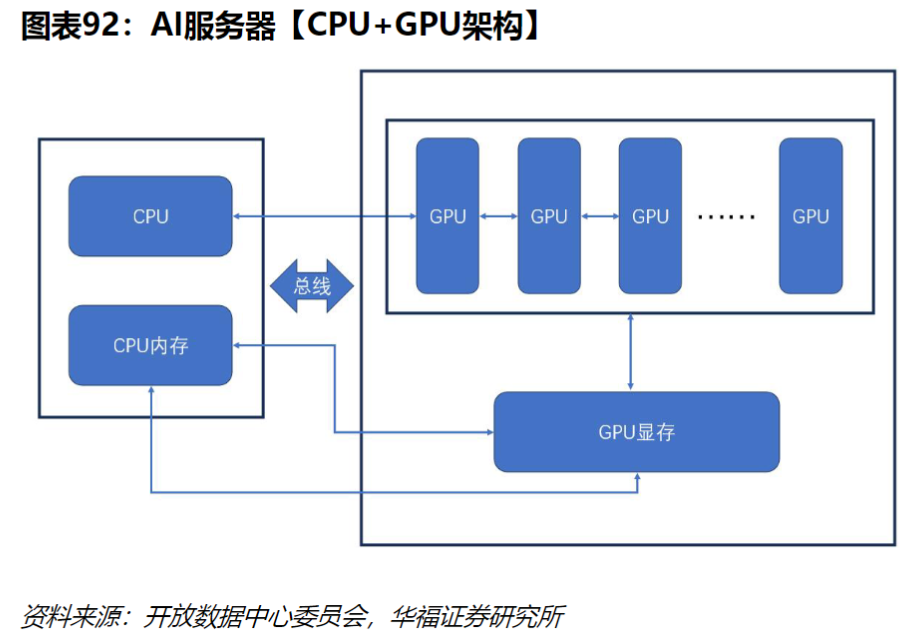

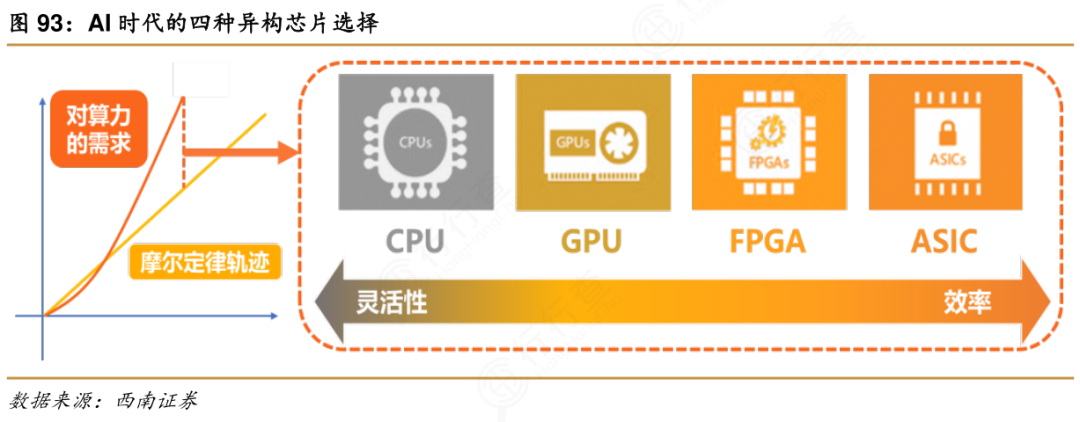

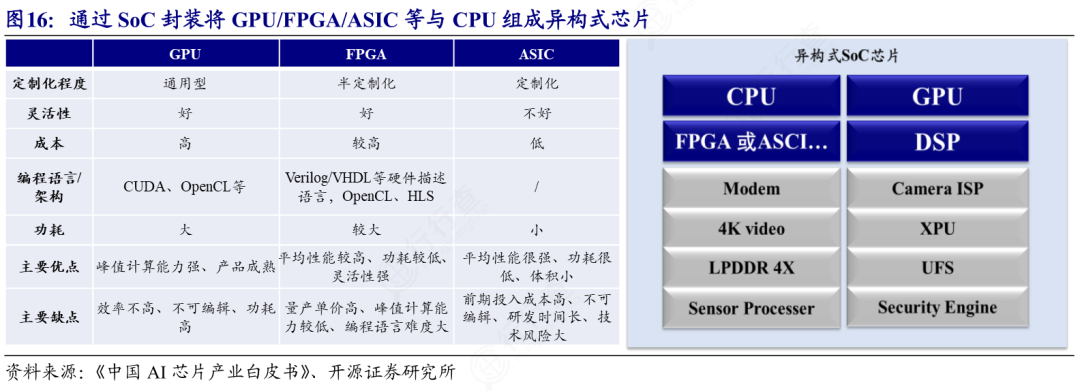

2)按异构架构分类

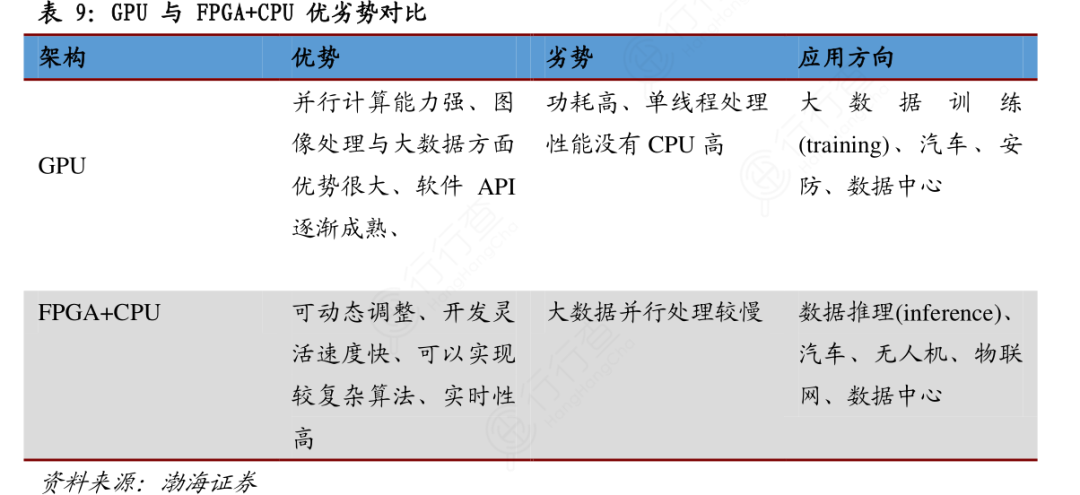

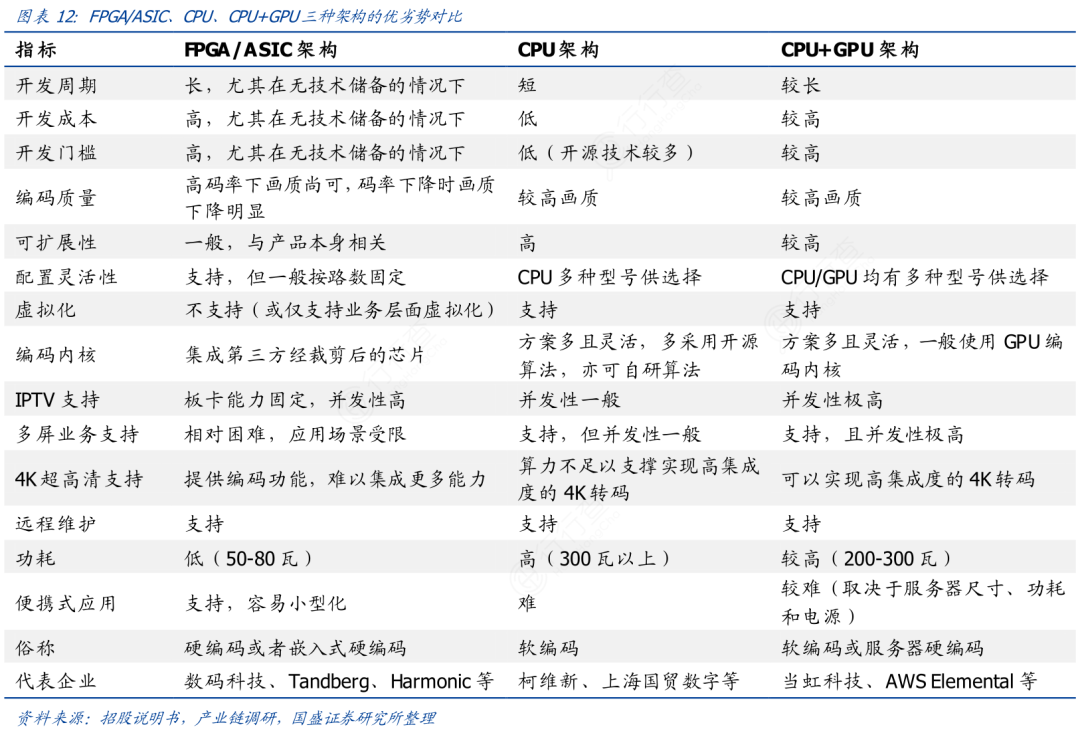

CPU GPU架构,这是通用性最强的主流架构,凭借GPU强大的并行计算能力,适配多数AI训练与推理场景,兼顾算力灵活性与任务适配性。

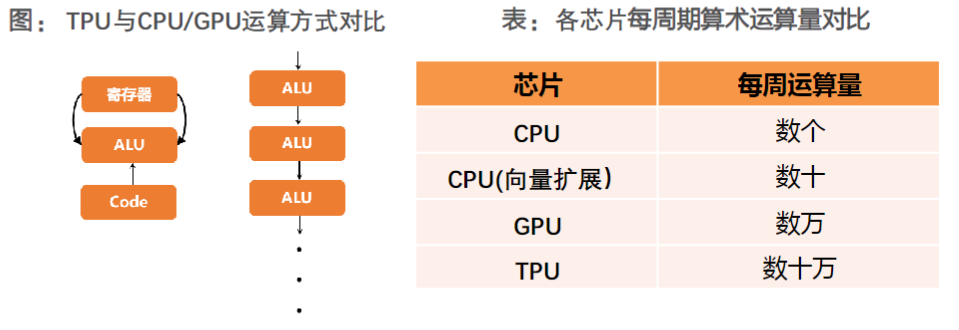

CPU TPU架构,是专为深度学习张量运算优化,针对特定框架与模型类型提升计算效率,聚焦矩阵运算密集型任务。

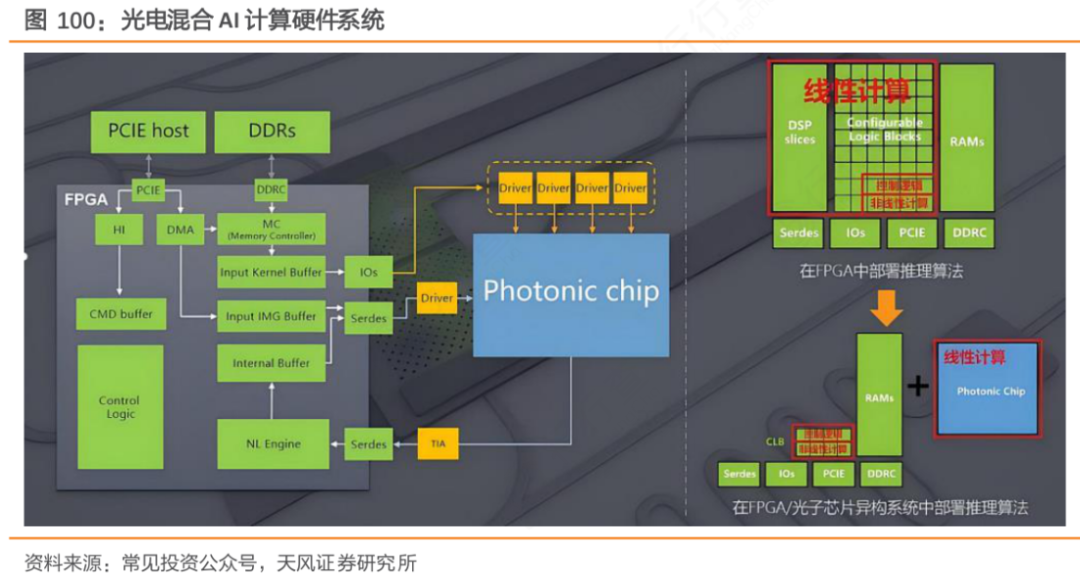

CPU FPGA架构,具备可编程特性,支持算法灵活迭代升级,兼顾算力性能与场景适配灵活性,适用于定制化推理场景。

CPU ASIC架构:为特定AI任务定制化设计,通过硬件结构优化实现极致能效比,聚焦单一场景的高效算力供给。

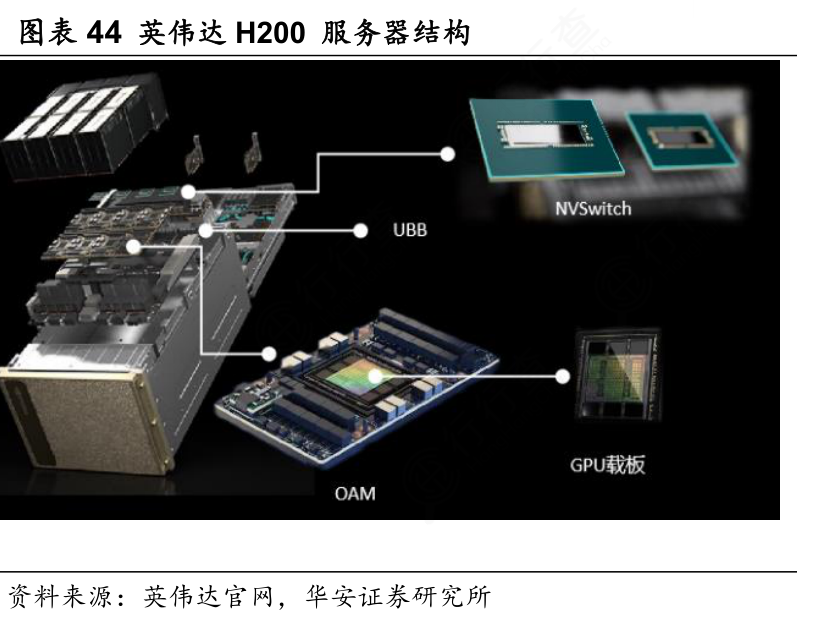

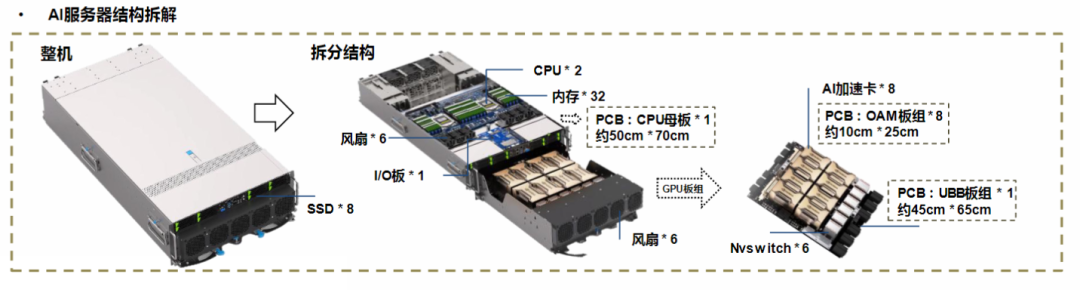

AI服务器关键组件

AI服务器关键组件

1)异构加速芯片

GPU擅长海量数据并行处理与浮点运算;TPU,张量处理专用芯片,针对深度学习核心运算流程优化,减少数据搬运延迟,提升张量运算效率,适配特定框架的规模化部署。

FPGA,支持算法逻辑动态重构,可根据场景需求调整硬件运算流程,兼顾算力性能与技术迭代灵活性。ASIC是专用集成电路,它基于特定的AI任务运算特征定制硬件结构,适用于场景化专用AI服务器的部署。

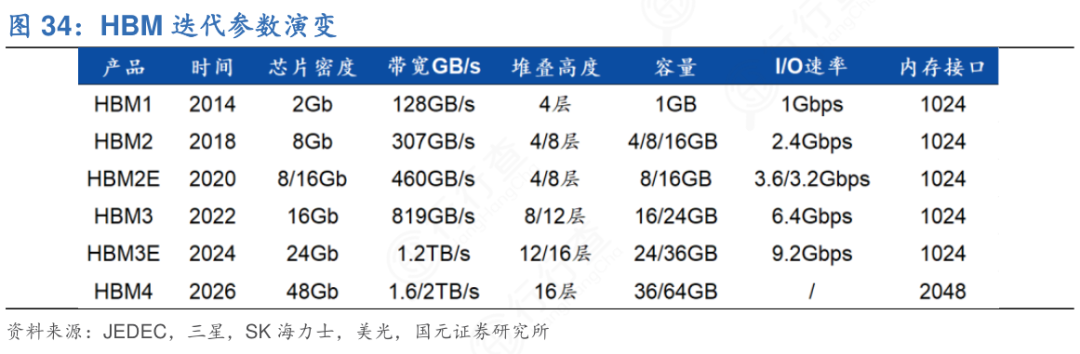

2)高带宽内存(HBM)

高带宽内存(HBM)采用3D堆叠封装技术的高性能内存解决方案,通过缩短存储与计算核心的物理距离,突破传统显存的带宽瓶颈。具备更高带宽、更低延迟及更优功耗,满足AI任务中海量参数的高速访问需求。

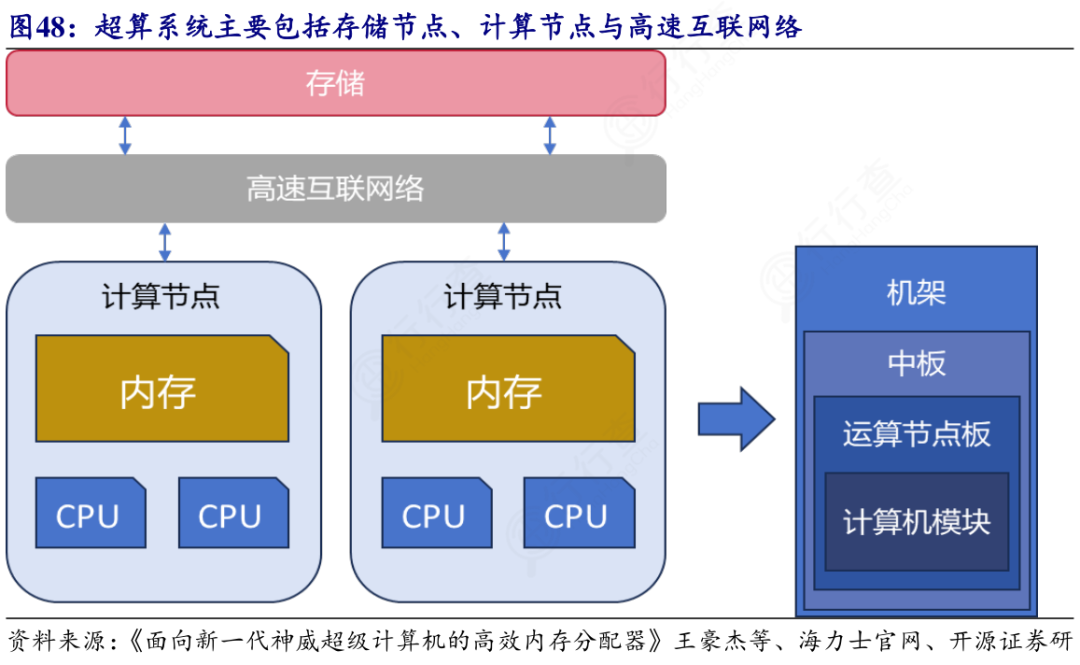

3)高速互联芯片与接口

高速互联芯片与接口,可以实现计算芯片间、服务器节点间的高效数据传输。它以低延迟、高带宽及高稳定性为核心设计目标,通过专用协议优化,减少数据传输过程中的协议转换与延迟损耗。主流类型包括:芯片间直接互联技术、远程直接数据存取(RDMA)相关接口,以及机架级交换芯片。

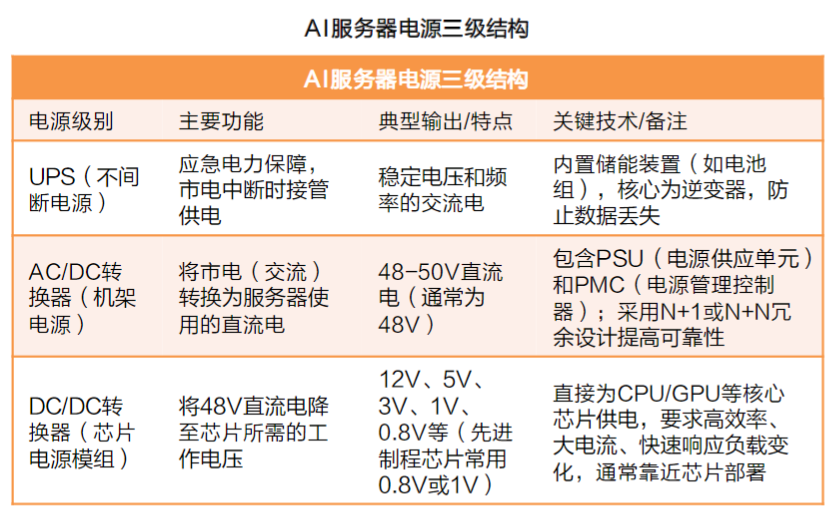

4)高功耗适配电源系统

针对AI服务器高密度算力配置的功耗需求,采用高功率密度电源模组,保障满负荷运行时的稳定供电。电源系统应具备冗余设计,支持智能功耗调控,并采用高效电源转换技术,降低供电过程中的能量损耗。

5)专业散热方案

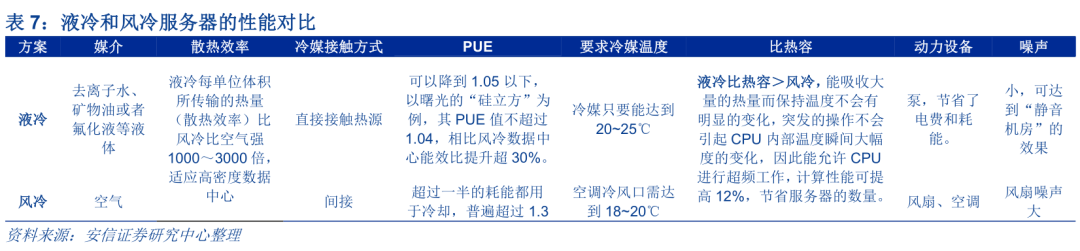

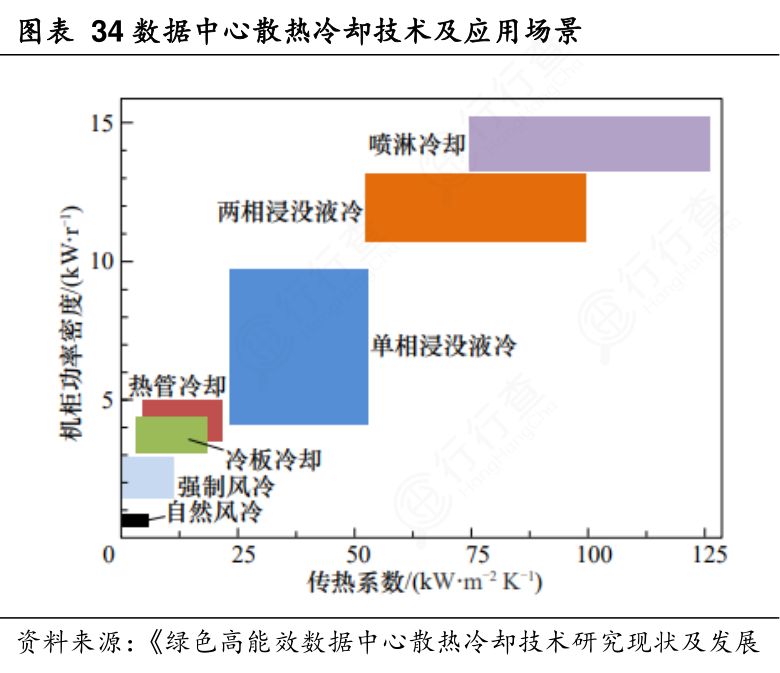

包括风冷与液冷两大主流方案。风冷技术是通过优化风道设计与高密度散热风扇,实现中低算力密度服务器的高效散热,具备成本可控、维护便捷的优势。

液冷技术包括冷板式与浸没式等形式,通过液体传热效率优势,解决高密度算力集群的散热难题,显著降低散热能耗与设备运行温度。

AI服务器典型应用场景

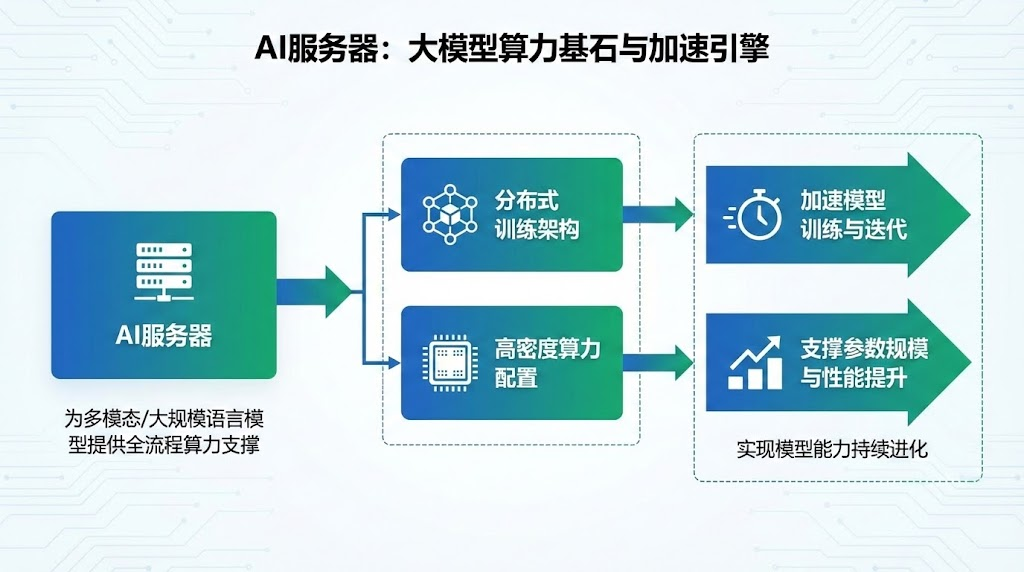

1)大模型训练与迭代场景

AI服务器为大规模语言模型、多模态模型等提供全流程算力支撑,通过分布式训练架构与高密度算力配置,加速模型训练进程与版本迭代,支撑模型参数规模与性能持续提升。

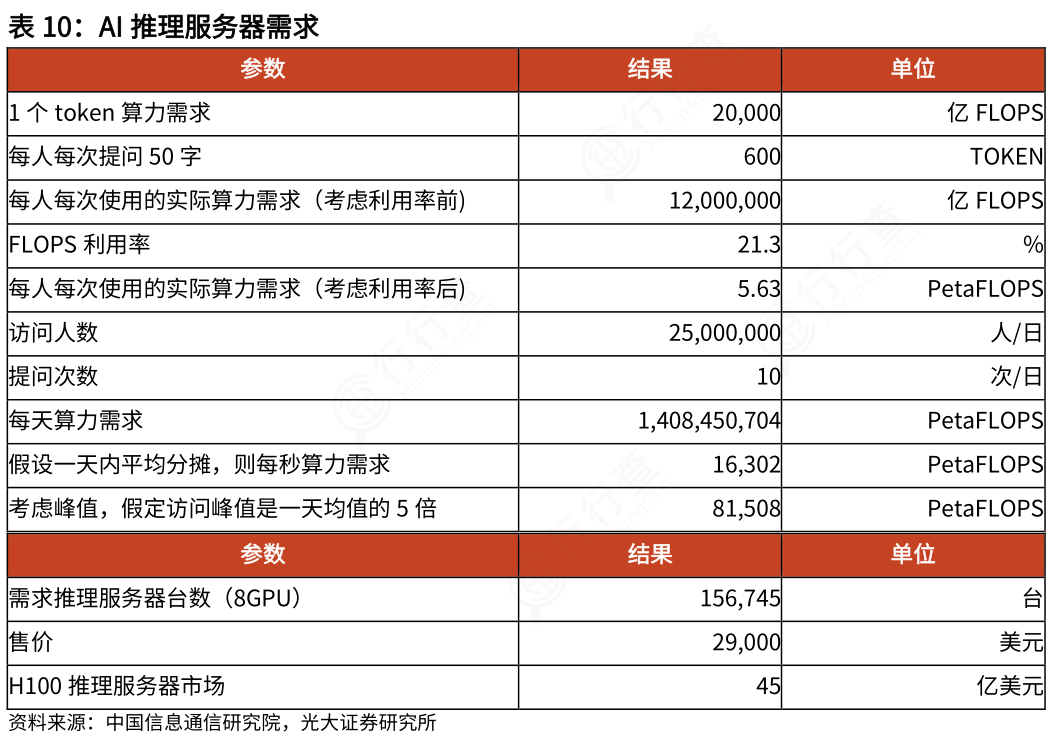

2)云端推理服务场景

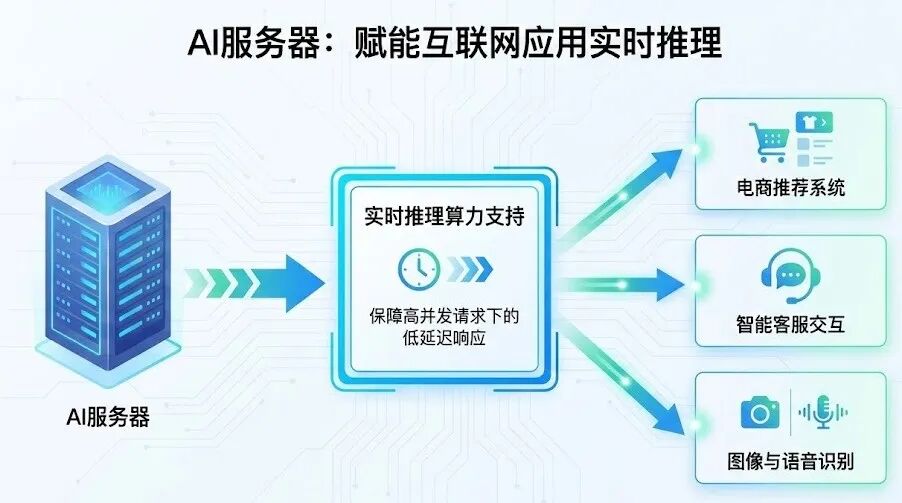

面向互联网平台的各类AI应用,AI服务器可提供实时推理算力支持,包括电商推荐系统、智能客服交互、图像与语音识别等场景,保障高并发请求下的低延迟响应。

3)自动驾驶算力支撑场景

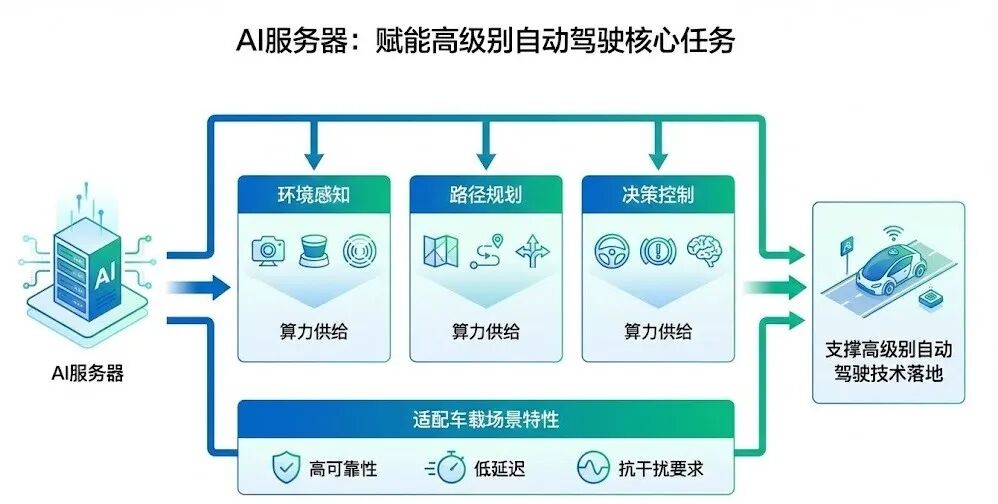

AI服务器可以为自动驾驶车辆提供环境感知、路径规划、决策控制等核心任务的算力供给,适配车载场景的高可靠性、低延迟与抗干扰要求,支撑高级别自动驾驶技术的落地。

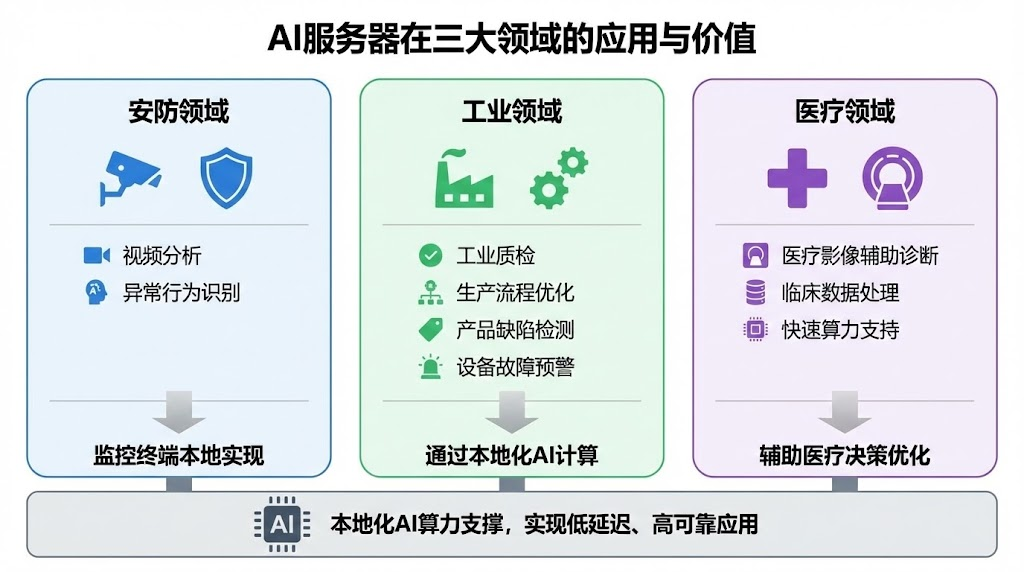

4)边缘AI终端适配场景

AI服务器应用在安防领域,监控终端本地可实现视频分析、异常行为识别等AI任务;在工业领域,适配工业质检、生产流程优化等场景,通过本地化AI计算,实现产品缺陷检测、设备故障预警等功能;医疗领域,AI服务器支撑医疗影像辅助诊断、临床数据处理等本地化,为临床诊断提供快速算力支持,辅助医疗决策优化。

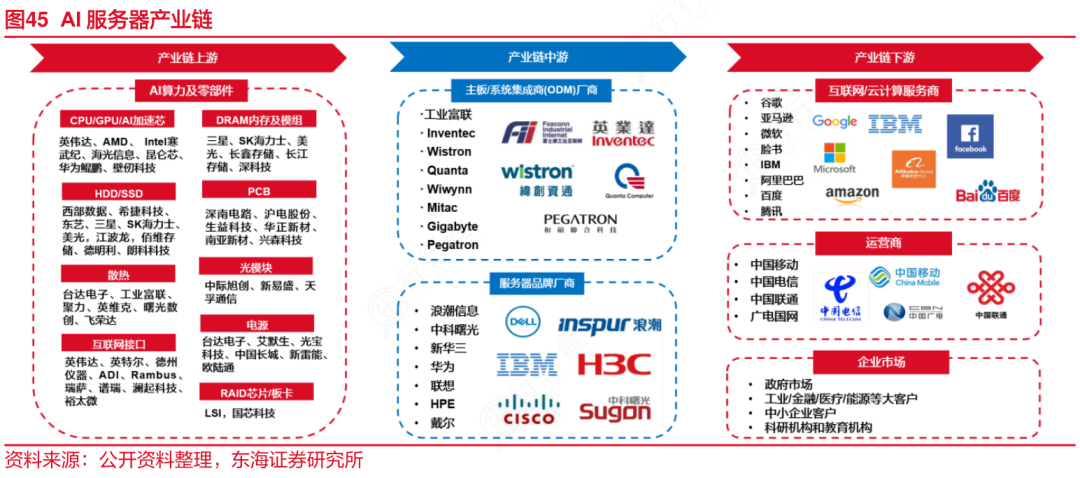

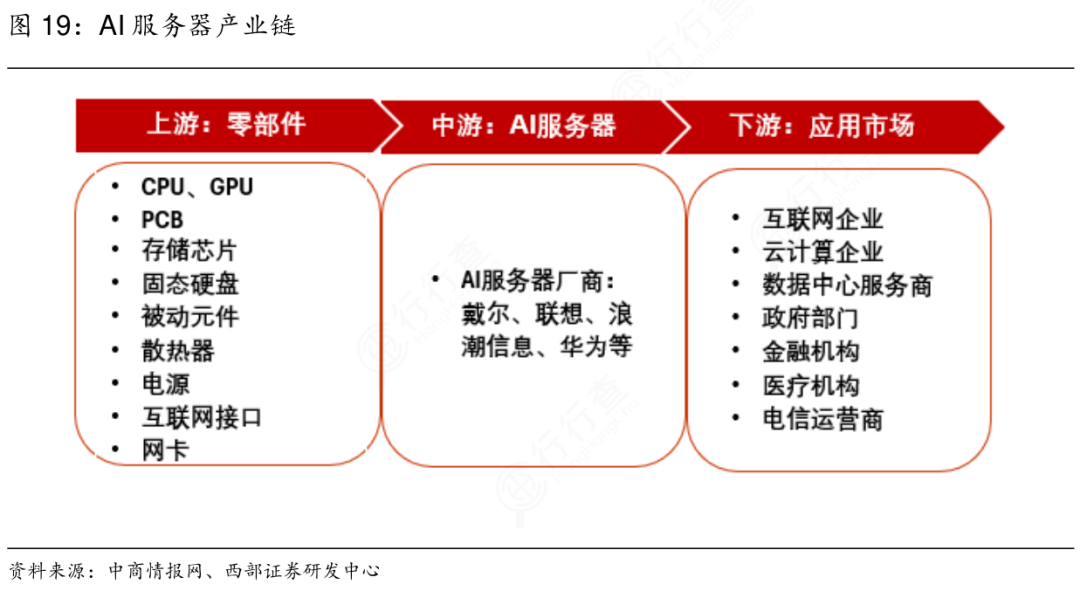

AI服务器产业链

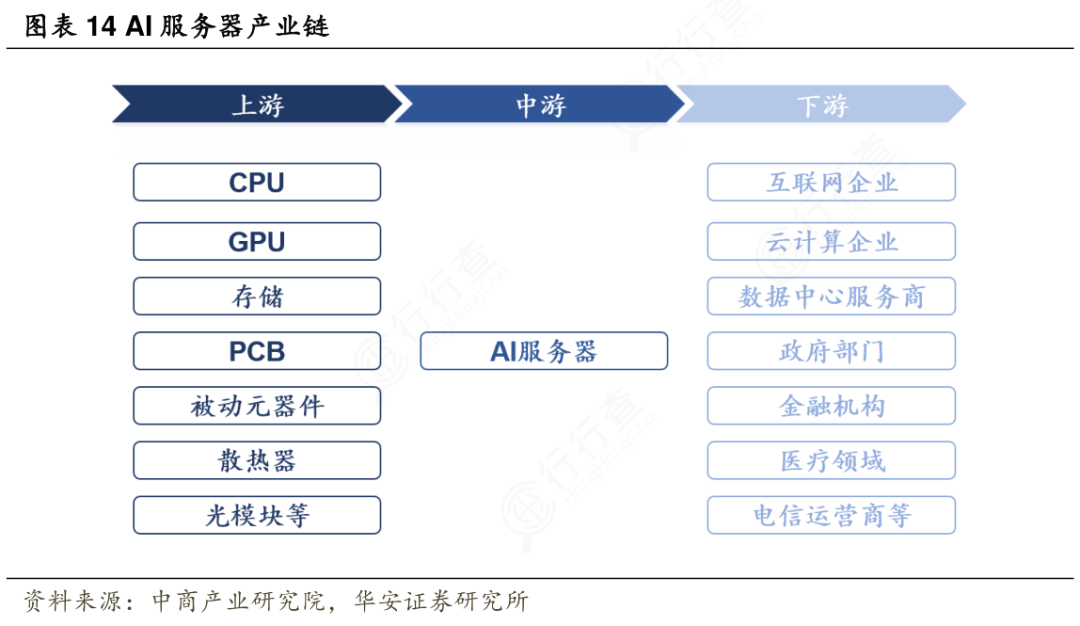

AI服务器上游聚焦核心零部件与基础技术供给,涵盖算力加速芯片、高带宽内存、高性能存储设备、高速互联组件等硬件,同时包括基础软件、芯片设计IP及相关技术授权服务,这些共同决定AI服务器的算力基础与性能上限。

中游核心环节包括服务器硬件设计、异构组件集成、系统调试与固件开发,同时涉及整机装配、兼容性测试及可靠性验证,通过标准化流程将上游零部件转化为具备完整功能的AI服务器产品,保障硬件与软件的协同适配。

下游聚焦应用场景与需求落地。主要覆盖云计算平台、智能终端部署及各行业智能化升级需求,应用领域包括大模型训练、自动驾驶、工业质检、医疗影像分析等。

AI服务器市场规模

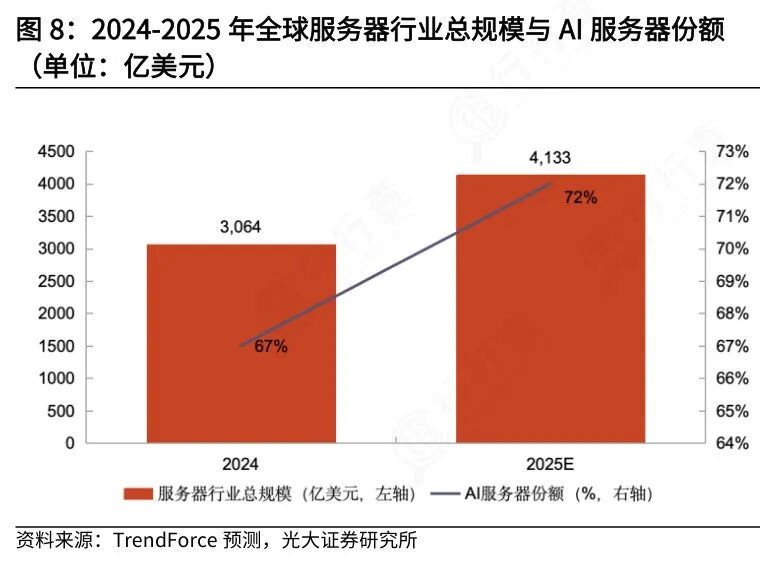

全球市场规模

根据TrendForce预计,2025年,受持续旺盛需求及高产品均价的共同推动,全球服务器市场规模预计超4000亿美元,AI服务器占比超过70%。

(数据时间:2025-8)

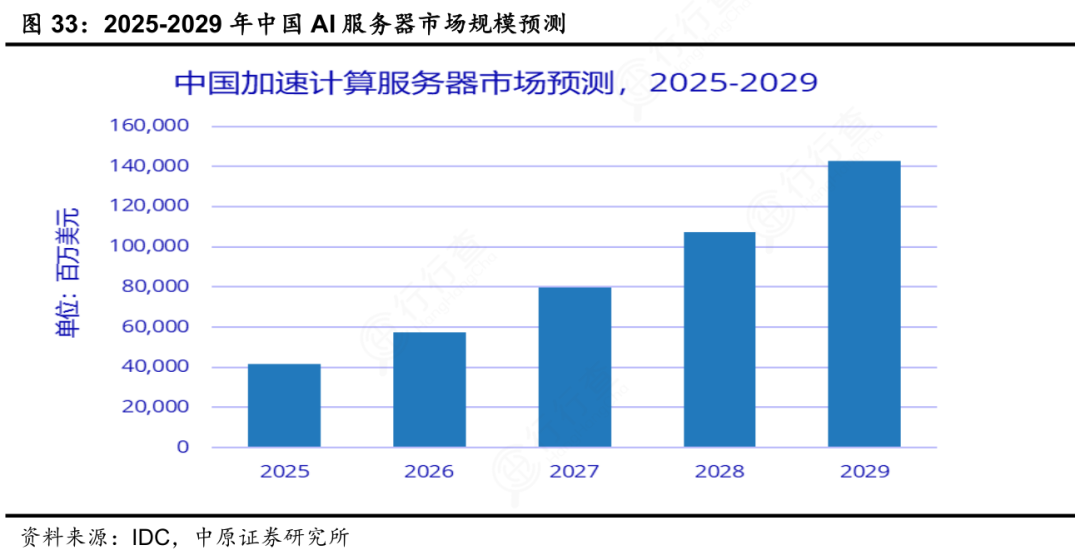

中国市场规模

根据IDC发布的数据,2025年我国AI服务器市场规模达到400亿美元,预计2029年将超过1400亿美元。

(数据时间:2025-10)

AI服务器相关企业

全球AI服务器龙头公司主要集中在 整机品牌厂商 和 核心零部件供应商 两个层面,产业链高度集中且技术壁垒高。

整机品牌端,浪潮信息 是全球AI服务器出货量第一的企业,市占率达20% ,产品广泛用于大模型训练;中科曙光 作为亚洲高性能计算龙头,深度绑定寒武纪、海光信息芯片;新华三(紫光股份旗下)在MLPerf测试中斩获多项世界第一;华为 依托昇腾 鲲鹏自研芯片体系打造全栈AI服务器;宁畅、超聚变、神州数码、联想、戴尔、惠普 等也在全球市场占据重要份额。

上游核心零部件环节:

GPU:英伟达占据90%市场份额,是绝对龙头;国内寒武纪、海光信息、景嘉微正加速追赶。

CPU:英特尔、AMD主导,海光信息、龙芯中科是国内主力。

存储:HBM由 SK海力士、三星、美光 垄断;DRAM/SSD领域,江波龙、佰维存储、兆易创新、澜起科技 是国内代表。

PCB:沪电股份、深南电路 为高端AI服务器主力供应商。

光模块:中际旭创、新易盛、天孚通信 受益于AI集群高速互联需求。

ODM代工:工业富联、广达、纬创、英业达是全球主要制造力量。

整体看,AI服务器产业由“芯片—组件—整机—应用”构成闭环,英伟达 浪潮 工业富联 中际旭创等组合基本覆盖了从算力到部署的核心链条。

中国企业在整机和部分零部件环节已具备全球竞争力,但在高端GPU和HBM等尖端领域仍依赖海外。

VIP复盘网

VIP复盘网