电子发烧友网综合报道,近日,Solidigm宣布率先推出用于无风扇服务器环境的冷板冷却企业级SSD(eSSD)。

SolidigmD7-PS1010E1.SSSD率先引入了单面直触芯片液冷技术,它提供行业领先的PCIe5.0SSD性能,适用于直连存储(DAS)AI工作负载。

Solidigm的直触芯片液冷eSSD让数据中心和边缘运营商的空间利用效率大幅提升,让GPU部署规模和密度的扩大成为可能。在尽可能地减少冷却基础设施需求的基础上,即使在物理空间有限的环境中,客户也能最大限度地部署计算能力。

SolidigmD7-PS1010冷板冷却eSSD专为领先AI服务器和下一代AI服务器架构设计,优势和特性包括:通过热插拔、单面冷板冷却技术,有效应对服务器散热管理和成本效益挑战;支持密集型AI工作负载的稳定运行,减少对存储设备的热影响;提供卓越性能,充分发挥Gen5的带宽优势,以满足AI工作负载的需求;降低运营成本,减少对风扇的依赖,最大限度提升热效率,并实现更紧凑的服务器设计。

凭借独特的创新散热设计,冷却能够精准传导至SSD双面的关键组件。这一设计不仅有益于设备在液冷和风冷环境下的无缝维护,更大幅提升了其性能表现。

SolidigmE1.S9.5mm和15mm两种尺寸规格,均提供3.84TB和7.68TB的容量选择。

Solidigm正在与领先的服务器ODM和OEM紧密协作,积极推进SolidigmD7-PS10109.5mm和15mmE1.SSSD在供应商以及其他各类AI和服务器解决方案上的验证工作。

Supermicro技术与AI高级副总裁VikMalyala表示:“将E1.S外形规格与冷板冷却eSSD技术相结合,无疑是一项重要的行业创新。这项技术已率先应用于我们先进的液冷架构——Supermicro NVIDIAHGXB300之中。Solidigm在打造完全无风扇液冷GPU服务器方面所付出的努力,对于加速计算密集型任务,以及满足AI数据处理各个环节的客户需求上,都起到了至关重要的作用。”

Solidigm高级副总裁兼产品与市场负责人GregMatson表示:“Solidigm冷板冷却eSSD在散热优化方面取得了突破性进展,为先进的GPU服务器带来了巨大的附加价值。这一单面冷板解决方案,由Solidigm率先推出,能够冷却SSD的两面,打造高效的存储子系统,有效缓解密集AI环境中SSD所承受的压力。”

英伟达HGX B300

英伟达HGX B300是英伟达推出的基于Blackwell Ultra架构的最新GPU产品。NVIDIA HGX 平台加速每个数据中心的AI和HPC的发展。

专为 AI 和高性能计算打造,AI、复杂模拟和海量数据集需要多个 GPU,这些 GPU 要具有极快的互连速度和完全加速的软件堆栈。NVIDIA HGX 平台将 NVIDIA GPU、NVIDIA NVLink、NVIDIA 网络以及全面优化的 AI 和高性能计算 (HPC) 软件堆栈的全部功能,可提供更高的应用性能,并加快获得见解的速度。

NVIDIA HGX 包含高级网络选项 (速度高达 800Gb/s),使用 NVIDIA Quantum-X800 InfiniBand 和 Spectrum™-X 以太网实现卓越的 AI 性能。HGX 还包含 NVIDIA BlueField-3 数据处理单元 (DPU),可在超大规模 AI 云中实现云网络、可组合存储、零信任安全性和 GPU 计算弹性。

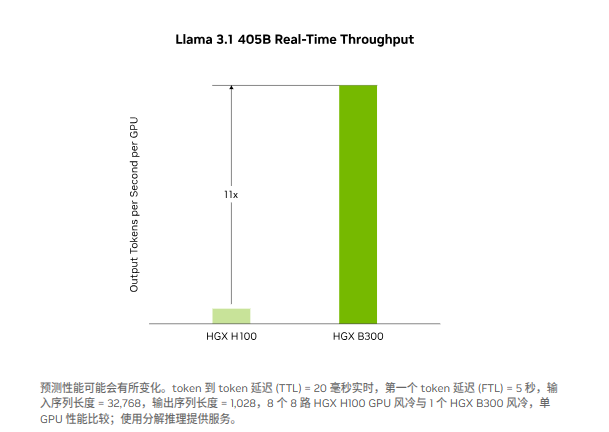

在AI 推理方面,以实时大语言模型推理为例,对于Llama 3.1 405B等模型,HGX B300的推理性能比上一代 NVIDIA Hopper 提升多达11倍。第二代 Transformer 引擎将定制的 Blackwell Tensor Core 技术与 TensorRT-LLM 创新相结合,加速大语言模型 (LLM) 的推理。

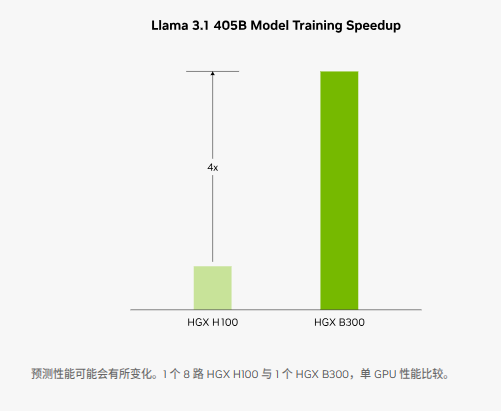

AI 训练方面,主打训练性能和可扩展性。第二代Transformer引擎采用8位浮点 (FP8) 和新精度,可使Llama 3.1 405B等大语言模型的训练速度显著提升4倍。第五代 NVLink(1.8 TB/s 的GPU到GPU互连能力)、InfiniBand网络和NVIDIA Magnum IO软件对这一突破起到了补充作用。这些因素共同确保了企业和广泛的GPU计算集群的高效可扩展性。

英伟达新一代Blackwell Ultra GPU全面采用液冷散热技术。据TrendForce集邦咨询,从第二季开始,ODM已针对英伟达GB200 Rack、HGX B200等Blackwell新平台产品逐步放量,更新一代的B300、GB300系列则进入送样验证阶段。因此,TrendForce集邦咨询预估今年Blackwell GPU将占NVIDIA高阶GPU出货比例80%以上。

VIP复盘网

VIP复盘网