全球算力需求高速增长,推动芯片功耗及数据中心单机柜功率密度持续攀升,传统风冷已难满足相关散热需求,具有更高散热效率的液冷或成为必选方案。同时,“双碳”宏观形势下,政府部门对数据中心PUE监管日益趋严,液冷作为降低PUE指标的有效方案,有望在数据中心中加速渗透。根据中国信通院的预测,2023—2027年期间,中国液冷数据中心市场将以59%的复合增长率持续蓬勃发展。

以下内容我们就沿着液冷行业的持续发展趋势,对相关问题展开分析梳理。当前液冷市场的现状怎样?驱动该行业发展的具体因素有哪些?不同的液冷技术方案分别是怎样的?以及该行业的产业链情况如何?有着怎样的市场格局?相关公司发展情况如何?行业后续整体的市场空间有多大?立足以上问题,我们为大家一一解析。

01

行业概况

1、智算算力单机柜功率提高,传统风冷已无法满足制冷需求

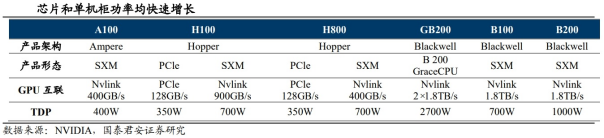

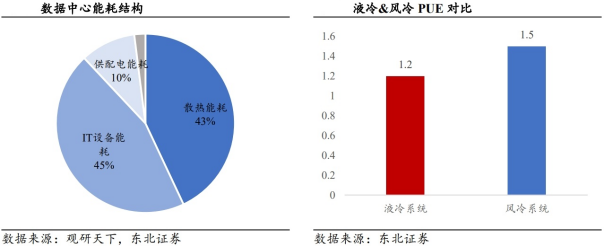

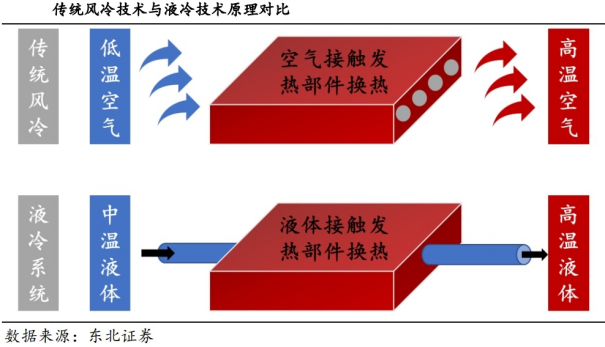

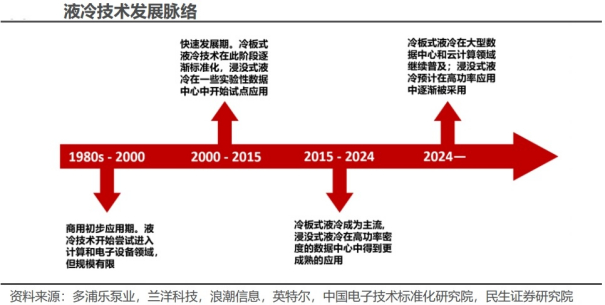

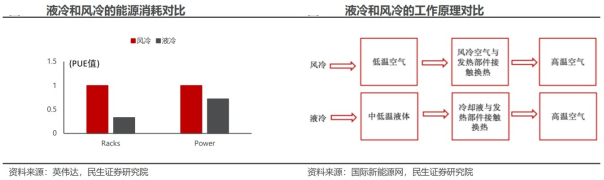

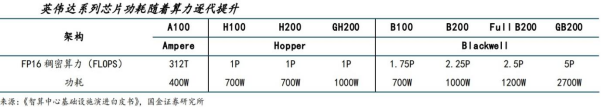

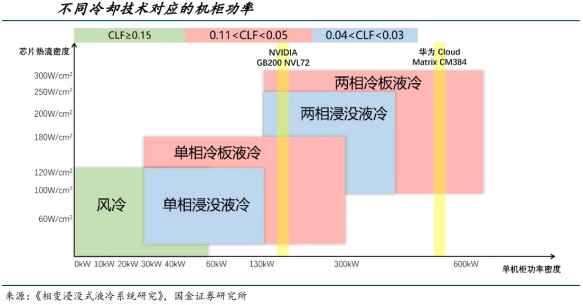

随算力需求的提高,芯片TDP逐渐提高。大模型训练以及推理对于芯片性能提出了更高要求,同样功耗和散热量也在不断攀升。相应数据中心单机柜的热密度将会大幅度的快速提升,智算中心机柜呈现高密度化趋势。以英伟达的芯片为例,A100的单颗芯片的功率为400W,H100、H200单颗功耗大幅提升,H100达700W,GB200达2700W,从芯片到服务器再到机柜,功耗数量级显著提升。2024年发布的搭载B200芯片的NVL72液冷机柜功率密度已经达到了120kW。随着芯片算力的提升,单颗芯片TDP(Thermal Design Power,热设计功耗)逐渐升高,对机房的散热性能也有了更高的要求。伴随算力需求的不断提升,液冷已然成为数据中心的关键解决方案。在数字经济加速发展背景下,数据中心已然成为全球信息交互的核心基石。2019-2023年,我国数据中心在用机架数量由315万架增长至810万架,CAGR为26.63%,截止2024年6月底,我国在用数据中心机架数达到830万标准机架,算力总规模达到246亿flops,其中智能算力规模超过76亿flops。面对日益膨胀的算力需求和存储需求,数据中心面临着能耗攀升与热量管理的严峻考验,因此,液体系统凭借其出色的热控效能与巨大的节能潜力,已然成为确保数据中心可持续发展的重要法宝。液冷系统在散热效率、能耗降低、设备寿命延长以及环境适应性等方面具备显著优势,因此取代风冷趋势已然定局。高效散热:相比于风冷,液冷散热效率更高,有助于大幅提升数据中心的散热效率,从而实现降低能耗。液冷技术是利用液体作为冷却介质,其载热能力、导热能力以及强化对流换热系数均远超空气,约为20倍左右。降低能耗:液冷系统凭借着高效散热能力,数据中心可以采用更高的服务器功率密度,同时保持较低的运行温度。这有助于降低数据中心的能源消耗,从而提高能源使用效率。据专业机构测算,液冷数据中心的电源使用效率(PUE)可降至1.1至1.2左右,显著低于风冷数据中心的PUE值。延长设备寿命:液冷技术能够显著地降低CPU的核心温度,进而有效延长服务器的运行寿命。依据芯片10℃法则,及每当温度升高10℃,电子元器件的寿命就会大约缩减一半。而采用液冷技术,可以使CPU的核心温度下降超过10℃。除此之外,温度对电子产品的影响不仅限于寿命缩短,还会导致其他问题。例如,高温会导致材料间热应力不同造成的开裂、膨胀收缩变形、电参数变化以及温度变化产生的冷凝等问题。降低运维压力:在液冷环境中,风扇的使用可以大幅减少甚至完全省去,这不仅降低了噪音污染和灰尘积累,液冷系统能够更快速、有效地将芯片产生的大量热量传导到冷却系统,降低芯片温度,从而著减少了因过热而导致的故障率。举例来说,采用浸没式液冷技术的硬盘,其故障率相较于传统风冷技术要低大约50%。环境要求低:液冷机柜对环境要求低,在较大温差区域部署仍可获得较稳定的PUE。密度高:相比传统风冷机柜,液冷机柜的装机密度更高,是传统风冷机柜的约3~4倍,相同算力下节省机房面积约75%。目前,大部分数据中心温控仍以风冷为主,但伴随着AI大规模发展,算力需求将大幅提升,未来数据中心将持续升级,芯片和服务器功率将随之提升,风冷所提供的散热能力或将无法满足数据中心需求。因此,液冷将成为未来数据中心的核心系统。液冷技术作为一种高效散热解决方案,已逐渐在数据中心、高性能计算(HPC)和电子设备等高能耗领域中得到广泛应用。商用初步应用期(1980s-2000年):液冷技术开始尝试进入计算和电子设备领域,但规模有限。这一时期,液冷技术逐渐成熟,冷板式液冷初具雏形,成为高性能计算机、服务器和一些实验室设备的散热选择。快速发展期(2000年-2015年):进入21世纪后,电子设备的性能和热密度迅速提高,特别是在数据中心和高性能计算领域。这一阶段液冷技术的安装和维护成本逐渐下降,设备逐步小型化、模块化,开始在企业级服务器和数据中心中普及。冷板式液冷技术在此阶段逐渐标准化,因其设计灵活且与传统设备兼容性较好,得到广泛应用。同时,浸没式液冷在一些实验性数据中心中开始试点应用。多元化与标准化期(2015年-2024年):随着高性能计算需求的激增,液冷技术在高热密度的应用场景中进一步普及,特别是随着人工智能、机器学习和大数据的普及,数据中心和超级计算机对液冷技术需求增加。冷板式液冷成为主流应用,尤其在高性能计算和数据中心领域实现广泛部署,已成为许多现代数据中心的标准技术之一。同时,浸没式液冷在高功率密度的数据中心中得到更成熟的应用,喷射冷却、微通道液冷等创新技术也在特定应用中试点,推动液冷散热的多样化。未来发展趋势(2024年及未来):绿色数据中心的需求将推动液冷技术的创新,预计更多企业会探索液冷在大规模部署中的可行性。未来液冷技术可能会向自适应智能化冷却方向发展,通过物联网和人工智能技术实现实时的温度监控和动态调整。冷板式液冷在大型数据中心和云计算领域继续普及;浸没式液冷预计在高功率应用中逐渐被采用;新型智能化液冷技术将有助于推动数据中心和计算系统向绿色环保方向发展。

02

国内外市场现状

1、海外:龙头加速液冷需求增长与技术革新

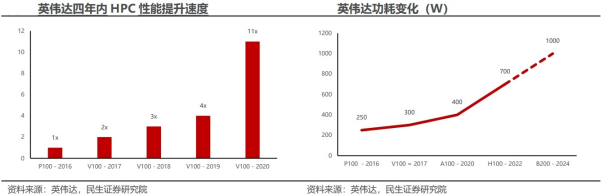

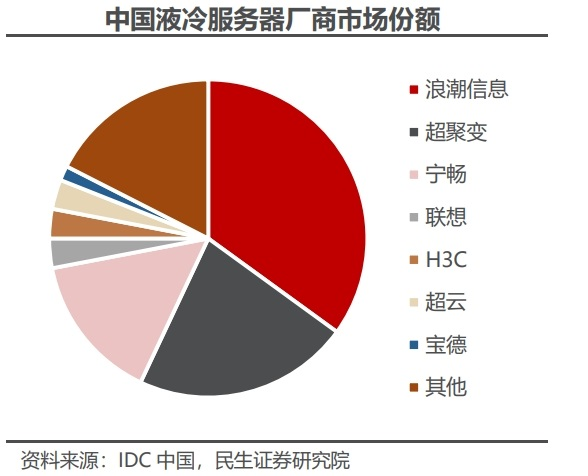

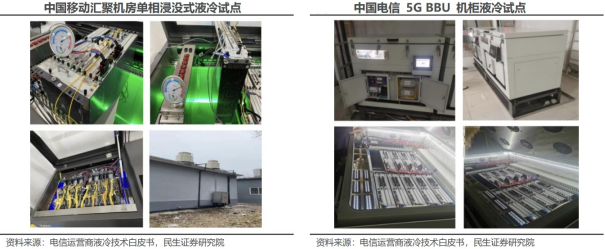

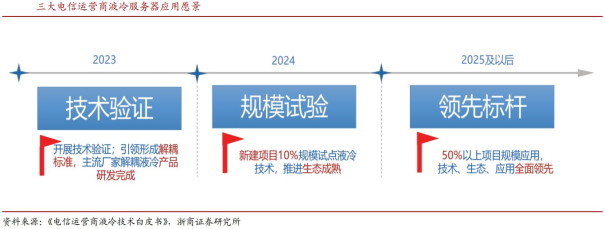

GPU性能迭代加速。随着高性能计算(HPC)和人工智能等计算密集型应用的快速发展,市场对更强大计算能力的需求不断增长,这一趋势带动了硬件功率需求的显著提升。以英伟达的GPU为例,从2016年的P100到2020年的A100,HPC性能提高了约11倍。然而,性能提升的同时,设备功耗也急剧上升。以英伟达的主要GPU产品为例:2016年发布的P100GPU的热设计功耗(TDP)为250W,2017年的V100增加到300W,而2020年的A100达到了400W。2022年发布的H100GPU在性能提升的同时,功耗进一步攀升至700W,预计于2024年发布的B200GPU,其TDP将达到1000W,对比2016年至最新的2022发布的H100功耗增长了180%。这种逐步增加的功耗反映了计算密集型任务的性能需求,而传统风冷方案已难以有效应对,液冷技术成为数据中心领域的关键方案。英伟达逐步推动数据中心的冷却革新。这一趋势带动了冷却技术的不断演进,从早期的风冷方案到现代的液冷和混合冷却技术。早期发展阶段(1993-2004年):其冷却技术经历了从基本风冷到改进风冷的过渡。最初GPU功耗较低,英伟达主要依赖传统风冷散热技术,通过散热片和风扇组合来满足需求。1999年,随着GeForce256的发布,英伟达引入了硬件变换和光照功能,被称为“世界上第一款GPU”。这一技术突破使GPU的功耗和热量显著增加,推动英伟达对风冷系统进行优化,采用更大面积的散热片和更高效的风扇,以提升散热效率并应对更强的性能需求。多GPU系统,SLI技术与散热挑战(2004-2010):2004年,英伟达推出SLI(Scalable Link Inter face)技术,允许多块GPU协同工作,显著提升性能。然而,多GPU布局带来了更高的热量,英伟达在散热设计上进行了改进,包括优化风道和增加散热片面积。液冷技术的引入应对高功耗(2022年):随着GPU功耗的持续上升,传统风冷逐渐难以满足散热需求。2022年,英伟达推出了基于A100芯片的首款液冷GPU,采用直接芯片冷却技术,以提升数据中心的能效。混合冷却方案风冷与液冷结合(2024年):维谛与英伟达的专家团队在深圳共同测试并发布了针对GPU高密度数据中心的创新制冷方案。实验在配置VertivTM Liebert®PCW、XDU液冷装置和AFC冷水机组的环境下进行,分析显示,约75%的IT负载可通过冷板液冷实现有效冷却,这一方案将服务器风扇的用电量减少了多达80%,使总体使用效率提高15%以上。与传统风冷相比,风液混合冷却方案在降低10%年度能耗的同时减少了同等比例的碳排放。此外,维谛还参与英伟达的COOLERCHIPS计划,共同开发集冷板液冷和浸没液冷于一体的混合冷却系统,该系统可在高达40°C环境下支持单机柜200kWIT功率,达到更高的运作效率和更低的碳足迹。液冷服务器市场近年来迅速增长,特别是在数据中心和高性能计算领域。根据工业和信息化部发布的《新型数据中心发展三年行动计划(2021-2023年)》,中国在推动绿色、低碳的数据中心技术应用方面制定了明确的发展目标,以及国际数据公司(IDC)发布了最新的《中国半年度液冷服务器市场(2023全年)跟踪》报告的最新数据,中国液冷服务器市场规模已达到15.5亿美元,同比增长52.6%。市场中的主流液冷解决方案以冷板式液冷为主,占比高达95%以上。这种增长背后是计算需求的激增,2023年市场前3大厂商(浪潮、超聚变、宁畅)合计占据70%的市场份额。这一高速增长背后是不断增加的计算需求,特别是来自人工智能、5G及云计算的推动。液冷技术不仅能够提高散热效率,还能显著降低数据中心的PUE值,有助于实现低碳环保的目标。三大电信运营商推进液冷技术标准化、创新应用与规模试点。自2012年起,中国移动开始在南方基地试点气液双通道冷板液冷技术,并取得年均PUE保持在1.2以下的成果。此后,公司逐步在呼和浩特、河北和山东等地应用冷板式和浸没式液冷技术,进行安全性、节能性等方面的测试。2023年,中国移动在呼和浩特的数据中心启动了液冷的大规模试点,旨在通过大规模应用和技术验证,推动液冷技术的产业化进程,降低数据中心PUE,并进一步建立完善的产业生态。中国电信在液冷应用和低碳化研究方面表现突出。2019年在贵州进行的大容量路由器冷板式液冷研究取得了显著节能效果,PUE值约为1.15,并因此获评“2021信息通信产业创新贡献奖”。此外,中国电信在多个5G基站和数据中心机房进行了喷淋式和浸没式液冷试点,以有效应对5G设备的高热量问题。2023年,中国电信将在京津冀数据中心和安徽等地增加液冷机柜的应用,计划通过大规模冷板式和浸没式液冷技术的部署,为数据中心的低碳高效运行提供技术支撑。中国联通在液冷技术的基础理论和应用扩展方面积极开展研究。专注于冷板式液冷的热阻分布、浸没式液冷的结构设计以及芯片散热的液冷适应性,形成了液冷冷却模型的理论基础,在郑州对5GBBU设备进行了液冷喷淋试点,PUE值达1.254,芯片温度有效降低,延长了设备使用寿命。中国联通计划继续在数据中心推进液冷应用,提升液冷技术的传热性能与成本效率,以实现更环保、低能耗的运营模式。

03

驱动因素

根据TrendForce预测,2025年液冷在全球数据中心的渗透率将从2024年的10%增长至20%以上,虽然风冷在存量市场仍占主导地位,但在算力需求提升、节能减排的社会目标下,液冷正在成为芯片/机架级冷却的主流解决方案。

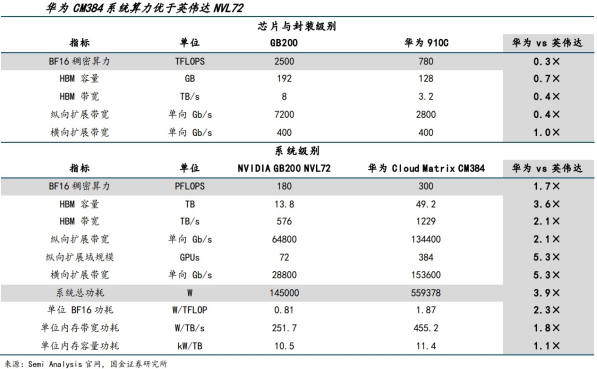

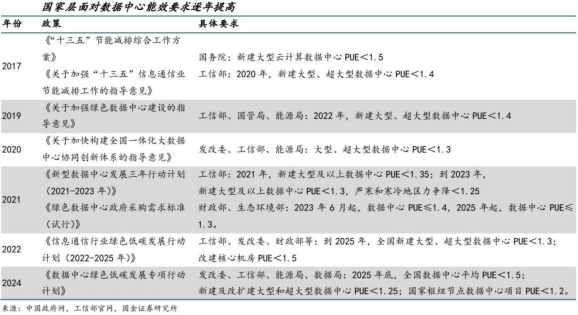

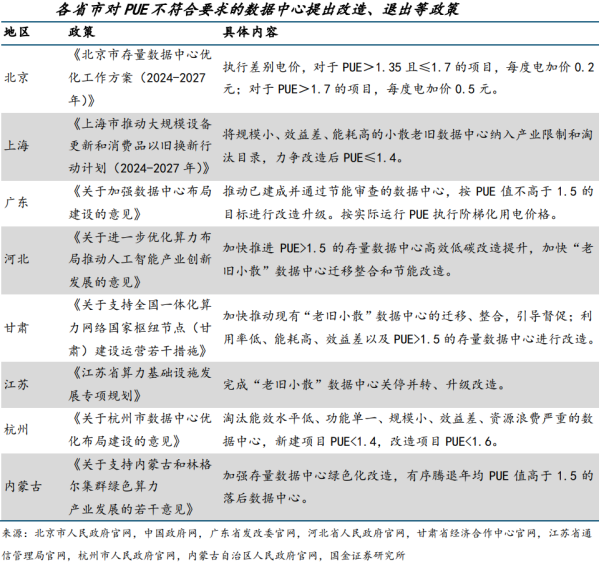

一方面,英伟达最新发布的GB300OEM/ODM供应商均采用全液冷方案;另一方面,2024年7月由四部委发布的《数据中心绿色低碳发展专项行动计划》提出,到2025年底,全国数据中心平均电能利用效率(PUE)降至1.5以下,而根据2025年6月1日新闻,最新一批“国家绿色数据中心”的PUE平均值已降至1.26,PUE指标持续下降是新建及存量数据中心改造的必然趋势。1、需求层面:智算中心催生高算力芯片,系统级功耗大幅提高ChatGPT引爆的生成式AI浪潮让智能算力需求呈爆发式上升,数据中心产业投资开始从通用算力中心迅速转向智能算力中心。通用算力是基于CPU提供的基础计算能力,智能算力是依靠GPU、FPGA、ASIC等芯片加速特定类型的运算;根据工信部印发的《算力基础设施高质量发展行动计划》定义,智能计算中心是通过使用大规模异构算力资源,包括通用算力和智能算力,主要为人工智能应用(如人工智能深度学习模型开发、模型训练和模型推理等场景)提供所需算力、数据和算法的设施。智算中心在芯片体系、网络拓扑和软件栈上都与传统数据中心存在本质差异,其核心价值在于按需聚合、调度GPU级别的高并行算力,机柜功率、带宽密度和服务器整机规模均远超传统云数据中心。为了满足不断攀升的算力需求,海外以英伟达为首,国内以华为为首的服务器供应商陆续推出匹配智算中心需求的芯片架构及系统方案:英伟达:Blackwell架构下已经实现量产出货的三款产品B100-B200-GB200,单芯片半精度(FP16)算力从1.8Pflops提升至5Pflops,同时最大热设计功率(TDP)从700W提升至2700W,从最新发布的B300/GB300来看,GB300算力较GB200提升50%,B300TDP较B200增加200W。华为:910B半精度(FP16)算力达320Tflops,最大功耗400W,2024年Q4推出910C,半精度(FP16)算力飞涨至780Tflops,相同任务下功耗降低30%。虽然从单芯片参数上,国内与海外还存在代差,但华为提出基于910C的纵向扩展解决方案CloudMatrix 384半精度算力达到英伟达GB200-NVL72的1.7倍,CM384通过多对多拓扑连接384个昇腾910C芯片,且由于横向及纵向拓展网络大规模采用400G光模块而非铜缆,总系统功耗较高、接近600kW。随着单芯片及机柜级功率密度提升,传统的风冷方案难以充分冷却设备,TGG建议把15-25kW机柜功率作为“未使用背板换热器等其他制冷设备”的风冷解决方案的上限,一般认为机柜功率密度20kW以上的人工智能集群不适宜采用风冷方案。据统计,英伟达GB300OEM/ODM厂商均采用全液冷架构。国内华为910C单芯片虽然还未达到必须采用液冷的功耗门槛,但从系统级能耗来看,CM384方案对散热提出了更高要求。2、政策层面:数据中心PUE指标趋严,老旧存量项目面临关停PUE(Power Usage Effectiveness)是评估数据中心效率水平的重要指标,PUE=数据中心消耗的所有能源/IT负载消耗的能源,其中IT负载消耗是指用于计算、存储和网络设备的电力和能源,PUE越接近1,数据中心的能效水平越好。作为“新基建”的数字底座与核心代表,数据中心在国家“双碳”目标战略框架下被赋予更高维度的绿色发展使命。国家层面对于大型数据中心PUE指标要求逐年提高,根据2024年7月国家发改委、工信部、能源局、数据局联合发布的《数据中心绿色低碳发展专项行动计划》,要求到2025年底,新建及改扩建大型和超大型数据中心PUE降至1.25以内,国家枢纽节点数据中心项目PUE不得高于1.2。除了国家层面对数据中心能耗指标提出硬性要求外,各省市对不符合要求的存量低效数据中心提出了严格的改造或关停要求。例如北京市《北京市存量数据中心优化工作方案(2024-2027年)》中提出引导全年电力能源消耗量在5GWh及以上、PUE>1.35的存量数据中心完成绿色低碳改造、转型为智能算力中心,2026年起对PUE值高于1.35的数据中心征收差别电价;上海市《上海市推动大规模设备更新和消费品以旧换新行动计划(2024-2027年)》中提出加快既有数据中心升级改造,将规模小、效益差、能耗高的小散老旧数据中心纳入产业限制和淘汰目录,加大高效制冷技术和新能源推广应用力度。在运行成本结构中,制冷系统一直是仅次于IT负载的第二能耗大户,当前数据中心制冷能耗占约20%-30%,传统风冷方案下能耗可达50%-70%,因此降低制冷系统的能耗可以显著提高数据中心的电能利用效率,相比空气,液体凭借更高的热传导效率,能够在更低的能源消耗下实现更好的散热效果,从而进一步降低PUE。

04

技术路径分析

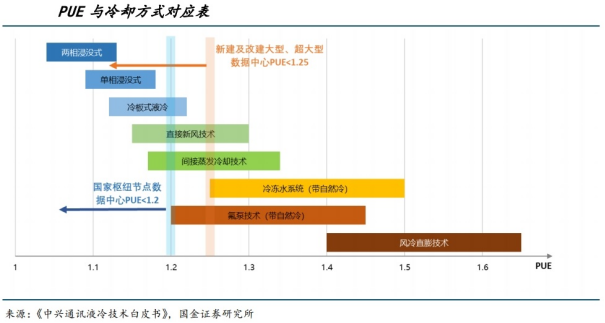

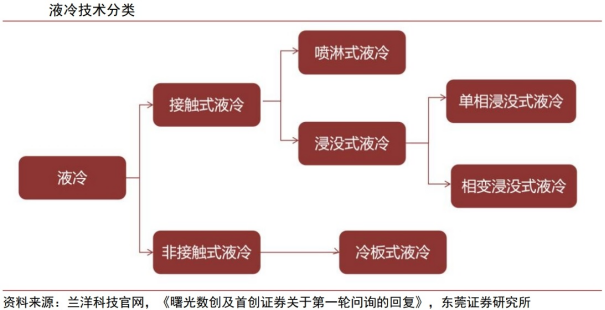

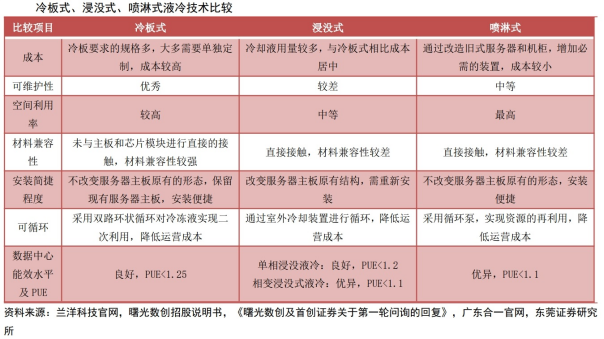

液冷技术可以细分为喷淋式液冷、冷板式液冷和浸没式液冷三种类型,主要区别体现在对服务器的散热方式不同。具体而言,喷淋式液冷是一种直接接触型液冷方式,通过向需要散热元件喷淋冷却液带走热量;冷板式液冷是一种间接接触型液冷,是将需要散热的元件固定在冷板上,液体通过冷板将热量带走实现散热;浸没式液冷是一种直接接触型液冷,是指将发热元器件完全浸没在冷却液中,吸收元件的热量。其中,浸没式液冷可以进一步分为单相浸没式和相变浸没式,二者主要区别在于冷却液升温后是否由液态转化为气态。采用这三种液冷技术下的数据中心能效水平良好,均可以实现PUE低于1.25,满足相关政策要求。

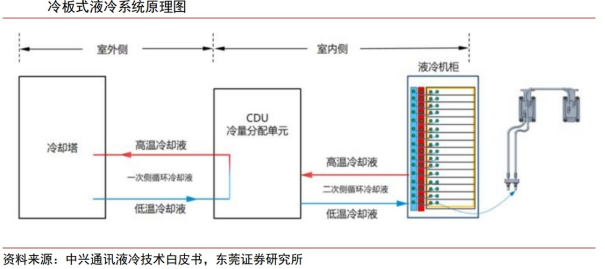

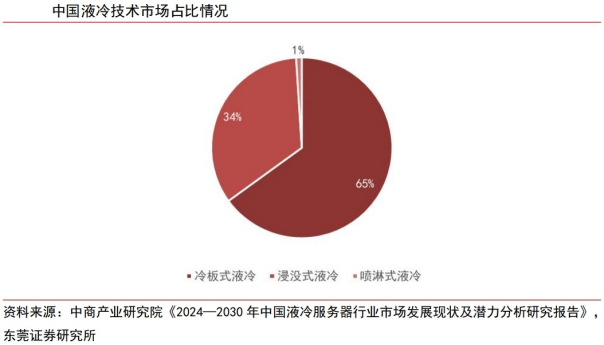

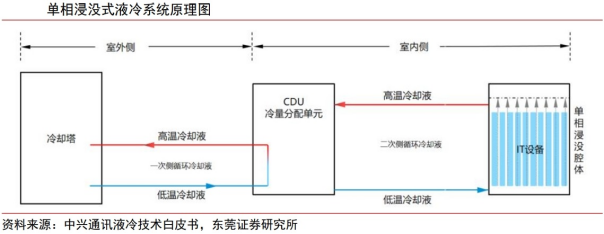

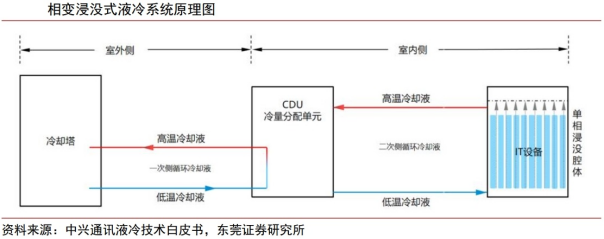

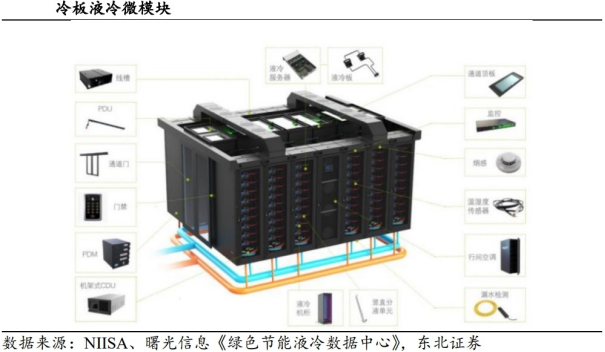

1、冷板式液冷:兼容性好、可靠性高,为当前市场主流冷板式液冷系统主要由冷却塔、CDU、一次侧&二次侧液冷管路、冷却介质、液冷机柜组成。液冷机柜内部则包含液冷板、设备内液冷管路、流体连接器、分液器等组件。在冷板式液冷系统运行过程中,服务器内发热元件产生的热量会迅速传导至紧密贴合在其表面的液冷板上。液冷板通常由铜、铝等高导热金属制成,具有优异的导热性能。同时,液冷工质(常见工质包括水、乙二醇水溶液、氟化液等)在CDU循环泵的驱动下进入液冷板,之后在其中通过强化对流换热吸收热量。随后,温度升高的工质通过CDU换热器将热量传递至外部的冷却设备(如冷却塔或热交换器)。在这些冷却设备中,热量被释放到周围大气环境,工质的温度得以降低。冷却后的工质将再次通过循环泵返回至液冷板,从而开始新一轮的散热循环。冷板式液冷技术占据当前国内主要市场,具有较高兼容性、可靠性。冷板式液冷技术较早引入中国市场,具有10年以上的技术积累,目前在三种主流液冷技术中成熟度最高、应用范围最广。根据中商产业研究院数据显示,当前我国冷板式液冷市场占比高达65%,而浸没式液冷和喷淋式液冷市场占比分别为34%和1%。冷板式液冷方案主要有散热效率高、兼容性好、可靠性高等技术优势。具体而言,首先,与传统的风冷技术相比,冷板式利用液体的高比热容等特性能够实现更高效散热,从而提升设备的稳定性和使用寿命,并可有效降低数据中心的PUE值至1.25以下,远低于传统风冷方案的1.5左右。其次,冷板式液冷技术具有较好的兼容性,其可以在保留现有的服务器主板等硬件架构下进行改装,在技术及规模化生产上具有较高的可行性。此外,由于冷板式液冷技术中冷却液与设备不直接接触,减少了因液体泄漏导致的设备损坏风险,该技术具有较高的可靠性。但是,与直接接触型液冷方式相比,冷板式液冷技术在热交换受到液冷板的限制,散热效率相对较低。浸没式液冷是一种通过将发热器件直接浸没在冷却液中,发热器件与冷却液直接接触进行热交换的散热方式。浸没式液冷系统室外侧包含冷却塔、一次侧管网、一次侧冷却液;室内侧包含CDU、浸没腔体、IT设备、二次侧管网和二次侧冷却液。按照热交换过程中工质是否存在相态变化,浸没式液冷可进一步分为单相浸没式液冷和相变浸没式液冷。单相浸没式液冷:在单相浸没式液冷方案下,CDU循环泵驱动二次侧低温冷却液由浸没腔体底部进入,流经浸没腔体中的IT设备带走发热器件热量。随后,吸收热量升温后的二次侧冷却液由浸没腔体顶部出口流回CDU;通过CDU内部的板式换热器将热量传递给一次侧冷却液;升温后的一次侧冷却液通过外部冷却装置将热量排放到大气中,从而完成整个制冷过程。由于要确保冷却液不发生相变,单相浸没式液冷通常采用沸点高,且满足绝缘性强、黏度低、腐蚀性小等性能要求的冷却液,例如碳氢化合物(矿物油、合成油、天然油等)、氟碳化合物等。相变浸没式液冷:相变浸没式液冷的传热路径与单相浸没式液冷基本一致,主要差异在于二次侧冷却液仅在浸没腔体内部循环。具有较低沸点和较高汽化潜热的液态冷却液(硅酸酯类、芳香族物质、有机硅、氟碳类化合物等)吸收IT设备热量,达到沸点后沸腾发生相变;汽化产生的高温气态冷却液逐渐汇聚到浸没腔体顶部,与安装在顶部的冷凝器发生换热后冷凝为低温液态冷却液,随后在重力作用下回流至腔体底部,实现对IT设备的散热。浸没式液冷具有散热效率更优、支持高密度部署、静音等优势。与传统风冷技术和冷板式液冷技术相比,浸没式液冷具有多项优势。在制冷能效方面,浸没式液冷是将发热器件直接浸入冷却液中进行散热,传热路径更短,换热效率高,能够有效降低数据中心PUE值。采用单相浸没式液冷技术可降低数据中心PUE至1.2以下,而相变式液冷由于在散热中发生相变,具有更高的传热效率,可进一步降低PUE值至1.1以下。在功率密度上,应用浸没式液冷技术可以大幅度提高数据中心单位空间的服务器密度,大幅提升数据中心的运算效率。传统数据中心采用风冷技术可冷却的单机柜功率密度通常为10kW-15kW,而浸没式液冷可以将单机柜功率密度提升到100kW甚至200kW以上,满足高密度计算场景对散热的需求。同时,机柜间无需隔开距离,机房内不需要空调和冷冻剂、无需架空地板、无需安装冷热通道封闭设施,机房空间布局可以更紧凑、更灵活,应用于地理环境或安装空间条件苛刻的数据中心中具有明显优势。在噪音方面,浸没式液冷技术无需配置风扇,可以实现极致“静音”机房。然而,浸没式液冷也具有一定的局限性。例如,区别于传统的立式机架结构,浸没式液冷采用的浸没腔体为卧式Tank,结构上具有颠覆性,对机房的改造成本和初始投资成本较高。此外,浸没式液冷常采用的工质如氟化液价格高昂且具有潜在毒性(致癌/激素紊乱等)等风险,部分冷却液还需要持续干燥处理,增加了运维复杂度。短期来看,冷板式液冷凭借兼容性强、改造成本低等优势占据了主要液冷市场,而浸没式液冷因为其高改造成本和运维难题限制了其实现规模化应用。但从长远角度看,随着未来冷却液价格下降、技术成熟度提升,在散热方面具有明显优势的浸没式液冷将逐渐成为未来高算力场景的必然发展方向,而具有更高散热效率的相变浸没式液冷或是终极液冷出路。3、喷淋式液冷:芯片级精准喷淋,技术成熟度相对较低喷淋式液冷是一种针对芯片级器件进行精准喷淋的冷却方式,其通过重力或系统压力直接将冷却液喷洒至发热器件或与其连接的导热元件上,属于直接接触式液冷。喷淋式液冷系统主要由冷却塔、CDU、一次侧&二次侧液冷管路、冷却介质和喷淋式液冷机柜组成。其中,喷淋式液冷机柜通常包含管路系统、布液系统、喷淋模块、回液系统等。喷淋式液冷的工作原理是通过动力设备(如泵压)将冷却后的冷却液从CDU中引出输送至喷淋机柜内部,并精准喷淋到服务器电路板上的发热元件。冷却液与发热元件直接接触,利用其高效的热传导性快速吸收并带走热量。随后,吸热升温后的冷却液将通过回液箱进行收集,并通过泵输送至CDU进行下一个制冷循环。作为直接接触式液冷方式,喷淋式液冷与浸没式液冷相似,同样具有散热效率高、支持高功率密度部署及静音等优势。但由于该技术目前成熟度相对较低,并且在冷却液喷淋过程中可能会出现液体飘溢和挥发等问题,容易影响机房环境的清洁度,实际应用案例相对较少,仅在少量数据中心中使用。

05

产业链分析

1、产业链概况

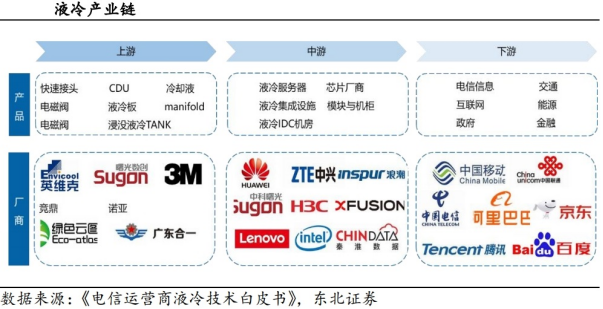

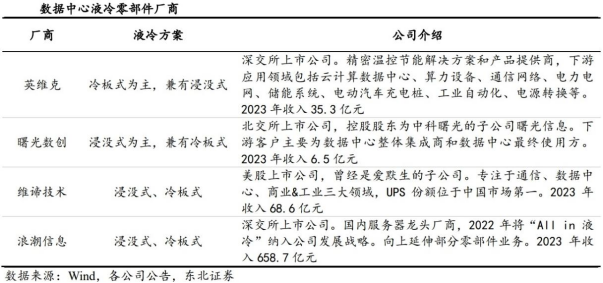

液冷产业链包括上游的产品零部件供应商、中游的液冷服务器供应商及下游的算力使用者。上游主要为产品零部件及液冷设备,包括快速接头、CDU、电磁阀、浸没液冷TANK、manifold、冷却液等组件或产品供应商,代表厂商有英维克、3M、云酷、竞鼎、诺亚、广东合一、绿色云图等。中游主要为液冷服务器、芯片厂商以及液冷集成设施、模块与机柜等,代表厂商有华为、中兴、浪潮、曙光、新华三、联想、超聚变、英特尔等。下游主要包括三家电信运营商,百度、阿里巴巴、腾讯、京东等互联网企业以及信息化行业应用客户,主要在电信信息、互联网、政府、金融、交通和能源等信息化应用。2、上游及下游是液冷解决方案商核心发力点,客户主要为互联网产业链维度看,上游及下游是液冷解决方案商核心发力点。上游供应链涵盖冷却液、电磁阀、浸没液冷设备、冷板等核心组件的提供商。全球知名的零部件供应商,如3M,在冷却液市场占据了主导地位,全球市场份额超过90%。在国内,英维克、新宙邦等公司是主要的核心零部件供应商,此外还有三花智控、TANK、Manifold等公司提供液冷系统的关键组件,如电磁阀和冷却设备。中游环节主要由液冷服务器制造商组成,包括液冷系统的研发、设计和集成。浪潮、超聚变、宁畅和联想等厂商在中国液冷服务器市场中占据重要地位,并积极推进液冷设备的创新研发。客户主要为互联网,当下资本开支扩张背景下液冷有望进一步受益。根据IDC的市场调研数据,2023年互联网行业占液冷服务器市场的46.3%,成为最主要的需求来源。这主要是由于互联网公司对计算能力和节能环保的需求不断增加,液冷服务器能够帮助其在密集计算场景下有效控制热量,减少能耗。此外,电信运营商、金融和政府等行业也在积极引入液冷服务器,以提升数据中心的运行效率。尤其是人工智能生成内容(AIGC)等新兴应用的快速发展,对计算能力提出了更高要求,进一步促进了液冷技术的推广。预计未来几年内,这些行业的液冷服务器需求将继续保持快速增长。3、行业尚处实验研究或初步应用阶段,国内参与厂商众多目前国际市场中主要厂商在液冷技术和产品方面还处于实验研究或初步应用阶段,市场中还未形成较强的龙头厂商。此外,由于中国对数据安全的保护,在数据中心基础设施的供应方面存在一定的地域壁垒,因此,目前国外厂商的产品的应用主要以其本国市场为主,进入中国市场较为困难。国内参与液冷的厂商众多,如零部件厂商英维克、曙光数创、维谛技术等,具备冷板式和浸没式技术,也包括中游的服务器厂商,如浪潮信息,向上延伸部分零部件业务。产品的核心竞争要素在于可靠性。液冷系统内包含的产品数量与工装复杂多样,由于缺乏长周期、大规模部署验证,客户选择供应商的重要因素在于液冷系统的稳定性和可靠性,能在全生命周期安全长效运行。由于液冷产业发展处于起步阶段、产业分工尚未明确,导致整个产业链的协同性不强,众多链条企业更多依靠“作坊式生产”的方式来完成产品及服务交付。具备高度资源整合能力的企业,能保证全链条材料兼容和全链条高效换热。上游零部件的客户壁垒较高。主要体现在:客户认证壁垒高。零部件需要和服务器适配,出于安全性、稳定性等考虑,客户在选择液冷数据中心基础设施供应商时通常需要进行严格的资质验证,如产品研发能力、产品供应能力以及售后服务经验;客户粘性强,考虑到产品的安全性和稳定性,客户不会轻易更换主要供应商,先进入者更易建立起客户资源,从而形成先发优势。

06

市场格局

从全球市场竞争格局来看,目前主要厂商在液冷技术和产品方面还处于实验研究和初步应用阶段,市场头部格局尚未固化。海外企业在液冷板、传统温控设备等领域占优。根据QYResearch数据显示,2022年,Aavid、Lytron、Asia Vital Components、Wakefield-Vette、Wolverine Tube五大海外厂商占据了全球液冷板市场约50%市场份额。而亚太市场特别是中国,在人工智能产业快速发展及国家政策支持共同驱动下,液冷领域正迎来快速发展期,一批具有竞争力的液冷厂商迅速崛起,在液冷服务器等细分领域中崭露头角。

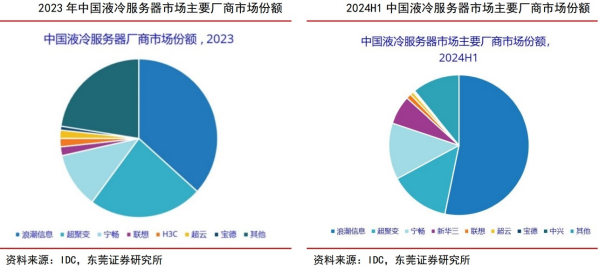

1、中国液冷服务器:头部市场份额增长明显,市场格局较为稳定中国液冷服务器市场集中度较高,2024H1浪潮信息占比超50%。中国液冷数据中心竞争方主要可以分为液冷服务器厂商和液冷基础设施服务商。液冷服务器厂商提供液冷服务器产品,同时可以联合基础设施厂商提供一体化的液冷解决方案,主流厂商包括浪潮信息、超聚变、宁畅信息、新华三、联想、中兴通讯等。根据IDC数据显示,截至2024H1,我国液冷服务器前四大厂商为浪潮信息、超聚变、宁畅和新华三,合计市场份额超过70%,市场集中度较高。对比2023年和2024年上半年数据来看,液冷市场中头部厂商份额增长明显。其中,浪潮信息蝉联中国市场第一,2024H1,占比全国液冷服务器销售额突破50%。新华三市场份额快速增长,2024H1,公司以绝对优势超过联想成为行业第四。浪潮信息:持续践行“All in液冷”战略。自2022年起,浪潮信息将液冷技术提升至公司核心战略层面,提出“All in液冷”战略。在产品方面,公司发布全栈液冷产品,实现通用服务器、高密度服务器、整机柜服务器、AI服务器四大系列全线产品均支持冷板式液冷,并持续进行全液冷机柜、机柜式冷量分配单元等创新,数据中心产品体系不断完善,目前公司产品及解决方案已相继在众多头部互联网公司实现批量化部署。在技术研发方面,截至目前,公司已拥有500多项液冷技术核心专利,并参与制定与发布了10余款液冷相关技术标准。2024年1月,浪潮信息携手英特尔发布全球首个全液冷冷板服务器参考设计,该服务器可实现接近100%液冷散热,系统无风扇运行,助力数据中心PUE可低至1.1以下。在交付能力方面,公司建成亚洲最大的液冷研发与生产基地,形成覆盖研发、测试、生产、品控、交付的全链条液冷智造能力,年产能超30万台。紫光股份(新华三):全面技术路线 全栈产品能力 全生命周期服务。紫光股份旗下新华三集团以“All in Green”为理念,积极推进全栈液冷产品应用和落地部署。公司全面覆盖冷板式液冷和浸没式液冷两大主流技术路线,多元路线协同确保最佳性能,助力数据中心实现PUE值最低降至1.1以下。新华三基于这些技术,已推出涵盖通用计算、高密1U计算和AI计算全系液冷服务器产品。从数据中心的设计、实施、验证到运维,公司提供全生命周期端到端服务,帮助用户消除落地瓶颈,充分满足不同计算场景的需求。2、中国液冷基础设施:市场竞争激烈,先发优势较为显著液冷基础设施市场竞争较为激烈,存在较高的进入壁垒,先进入者可以在实践中进行技术调优,积累服务经验和客户资源,从而占据先发优势。目前,该领域主要厂商包括曙光数创、英维克、申菱环境、同飞股份等企业,这些厂商各有技术及产品侧重,竞争差异性相对较小。

07

相关公司

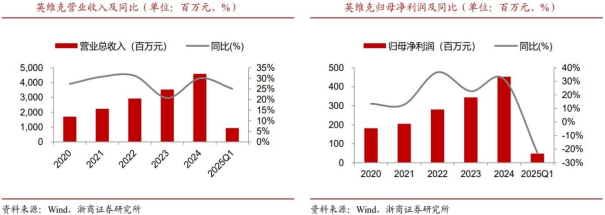

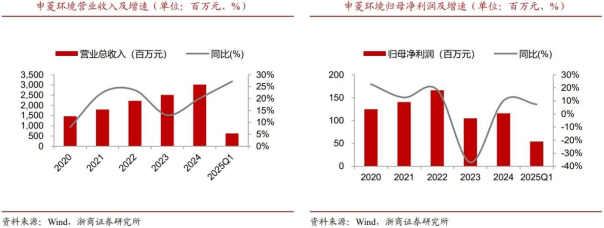

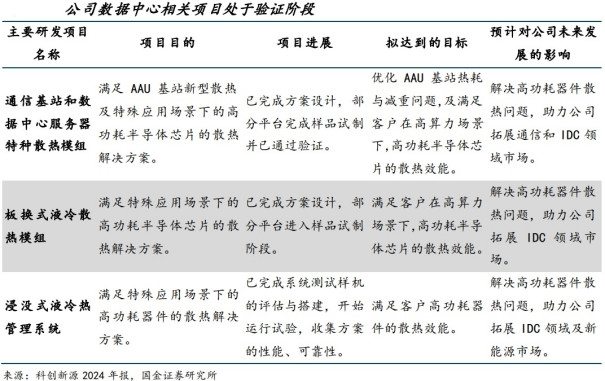

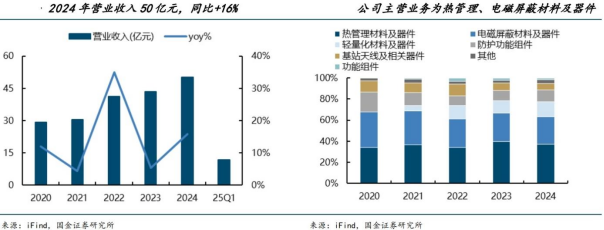

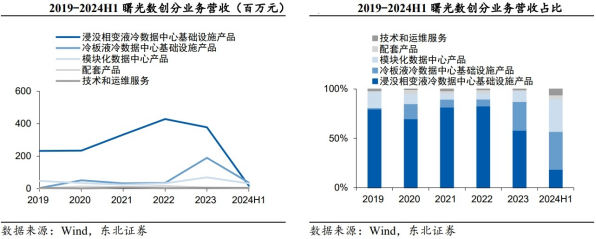

1、英维克:精密温控龙头,液冷技术领先

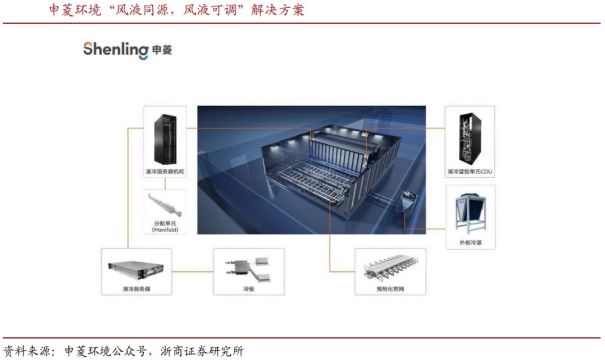

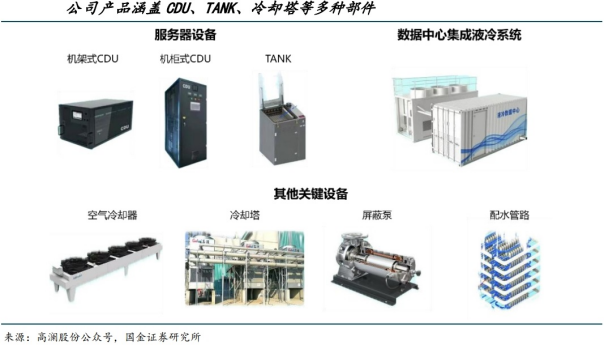

公司为国内精密控温龙头,AI算力需求带动液冷放量。依靠领先技术覆盖全国及全球重点区域市场,行业优势地位显著,随AI算力更高需求有望带动液冷市场放量。2020-2024年,公司营业收入从17.0亿元增长至45.9亿元,CAGR达28.1%,归母净利润从1.8亿元增长至4.5亿元,CAGR达25.6%。2025Q1受会计政策变更、大宗商品价格上涨影响,公司毛利率及净利率均有所下降。产品占比方面,数据中心温控产品占比较高,其中机房温控节能设备占比约为53%,户外机柜温控节能设备占比约为37%。英维克深耕数据中心温控领域近二十年,全链条液冷行业领先。英维克的高算力温控方案,采用风液兼容设计,弹性适配普算和智算中心,能够适配多场景的模块化方案。即使数据中心目前没有液冷服务器,也可以先按风冷服务器上架,后续据自身需求再升级液冷服务器。其在2021年就率先推出Coolinside全链条液冷解决方案。从热端的GPU/CPU芯片的冷板、过程中的管路、快速接头、Manifold、CDU、SoluKing数据中心长效液冷工质,再到一次侧的冷源等,英维克通过自主研发、自主生产、自主交付、自主服务,真正做到从热到冷的“全链条”解决方案,让液冷系统运行更可靠,确保液冷系统“四维一体,风险归零”。公司为国内专业空调领域领导者,在数据中心液冷散热技术上超前布局。公司早在2011年就已开始研究数据中心液冷散热技术,参与了中国移动南方基地的“数据中心液/气双通道精准高效致冷系统关键技术及应用”科研项目,在南方基地的主导下,与浪潮信息、新创意、华南理工等合作完成了定制液冷服务器及液冷散热系统的开发,搭建了国内较早的商用液冷微模块数据中心,并实现了长期稳定运行。2020-2024年,公司营业收入从14.7亿元增长至30.2亿元,CAGR达19.7%,受原材料价格及工业领域产品影响,公司归母净利润从1.25亿元略降至1.16亿元。产品层面,数据服务行业用温控设备占比持续扩大,至2024年占比已达51.3%。公司液冷解决方案持续突破,数据服务板块新增订单同比增长95%。公司随着智算、超算发展,超高热流密度散热成为核心,申菱创新提出“风液同源,风液可调”解决方案,采用全预制化、模块化的方式,缩短建设周期,根据实际需求灵活调节,实现弹性风液比,高质量快速交付,为数据中心的绿色、高效运行提供了强有力的支撑。2024年公司数据服务板块营收同比增长75.40%。除H公司业务持续增长外,来自互联网头部客户字节、腾讯、阿里等的营收规模都实现了快速增长,且公司数据服务板块新增订单同比增长约95%,随着订单陆续交付落地,相关业务将实现可持续的良性增长。公司深耕工业温控领域,数据中心液冷打造新增长极,多领域布局保持竞争优势。公司2001年创立以来,一直深耕工业温控领域,成为国内工业温控设备龙头企业,主营业务为液体恒温设备、电气箱恒温装置、纯水冷却单元、特种换热器四大板块。2020-2024年,公司营业收入从6.1亿元增长至21.6亿元,CAGR达37.1%,公司归母净利润从1.2亿元增长至1.5亿元,2025Q1公司业绩大幅增长,归母净利润达0.6亿元,同比增长1104.9%。产品结构方面,公司液体恒温设备占比较大,占比达67.9%。厚积薄发,布局数据中心液冷温控产品,主要产品包括液冷CDU、冷却水机组等。公司通过液冷技术创新和产品研发,为中国的IDC产业提供高效、可靠、智能的温控解决方案。公司数据中心液冷CDU产品,具有标配RS485接口,支持Modbus协议,能够实现远程监控,适用于高功率密度数据机房或者高节能需求数据中心;冷却水机组产品主要应用于计算机机房和数据中心,采用高效壳管式换热器,提高整体换热效率,通过自动化控制,提供专业的保护功能和友好的人机交互,达到高节能率、高适应性、全寿命低成本的效果。产品创新能力强,推出板式液冷及浸没式液冷全链条解决方案。该方案通过搭配CDU、浸没液冷TANK、一次侧冷源、环形管路及manifold等模块,实现充分利用自然冷源,系统更加安全可靠,同时可满足高功率密度换热需求,综合PUE可达1.04。4、高澜股份:综合性纯水冷却设备企业,浸没式技术先行者公司成立于2001年,是中国最早聚焦热管理技术创新和产业化应用的企业之一,公司产品主要分为大功率电力电子热管理产品和高功率密度热管理产品,与电力建设、数据中心、储能等下游领域密切相关。公司高功率密度装置热管理产品包括信息与通信液冷产品以及储能液冷产品,2024年收入占比接近50%,其中在数据中心液冷领域,公司产品涵盖服务器液冷板、流体连接部件、多种型号和不同换热形式的CDU、多尺寸和不同功率的TANK、换热单元等数据中心的关键部件,并围绕上述零部件,形成冷板液冷和浸没液冷数据中心热管理解决方案,液冷相关客户包括字节跳动、阿里巴巴、腾讯等。尤其在浸没式方案上,公司2023年推出定点浸没产品,相较常规全浸没液冷技术,具备定点冷却、精准用液等特点,在极低PUE的同时,可减少60%以上的工质用量;2024年,“数据中心模块化浸没式液冷设备”成功入选《广州市绿色技术推广目录》,公司研制的服务器浸没式液冷产品已应用在国内某知名互联网企业数据中心机房。5、科创新源:高分子与热管理系统领导者,数据中心散热业务布局扩大公司成立于2008年,主营业务为高分子材料产品及热管理系统产品的研发、生产及销售,其中热管理系统业务主要产品包括新能源汽车动力电池和储能系统用液冷板、传统家电散热器件、数据中心服务器用散热模组等。2023年公司设立创源智热,开展数据中心散热结构件业务,其产品包括虹吸式特种散热模组、液冷板等;2024年,公司部分产品通过客户认证,进入小批量试制阶段,为后续规模化生产与市场推广奠定基础;2025年,公司考虑到数据中心液冷板相关业务处于发展初期,决定采用协同制造与自主产销双轮驱动模式,协同制造上,创源智热积极切入行业头部企业供应链,承接适配订单,自主产销上,公司持续加大内部生产体系建设投入,提升自主交付能力,拓展市场份额。2024年底,公司与东莞兆科签署《股权收购意向协议》,拟以现金方式收购斯摩格有限公司持有的东莞兆科51%的股权,2025年5月公司宣布延展排他期限自《意向协议》签署之日起的十二个月内,东莞兆科主营业务为导热界面材料的研发、生产及销售,客户包括华硕、戴尔、富士康、台达、联想、英特尔等知名企业,收购后将进一步扩大公司在散热业务领域的产品布局,提高公司产品多元化水平,培育新的利润增长点。公司成立于1993年,主要从事电磁屏蔽材料及器件、热管理材料及器件、基站天线及相关器件、防护功能器件、轻量化材料及器件、功能组件等的研发、设计、生产与销售,其中热管理材料及器件包括导热界面器件、石墨片、导热石墨膜、散热模组、风扇、VC均温板、热管、压铸件及液冷板等,应用于数据中心服务器等场景。2024年公司实现营业收入50.31亿元,同比增长15.76%,AI服务器液冷相关业务开展顺利,凭借多年的散热技术积累与战略布局,公司与部分重要客户的业务合作有序推进,数据中心、服务器客户包括:华为、中兴、思科、浪潮、大唐移动、宝德、烽火超微、新华三、超聚变、联想等,相关业务已获得批量订单并量产。液冷散热产品方面,在单相液冷模组、两相液冷模组、3D-VC散热模组、轴流风扇及特种散热器的基础上,公司持续进行新技术及新产品储备,热虹吸散热器热性能研究、高性能液冷散热模组研发、高性能3DVC散热模组产品研发等核心技术均取得重要成果,其中3DVC散热器散热功耗可达1400W,处于行业领先水平。以高效冷却技术为核心竞争力,从研发至应用始终保持行业领先。公司成立于2002年,公司总部位于北京市中关村。公司成立之初主要聚焦于提供电气系统产品,如智能化机柜配电设备PDU、机房气流组织设备ADU等。公司分别于2008年和2010年推出风冷数据中心机房智能池级模块化数据中心产品C20 00和高功率密度排级模块化数据中心产品C1000。公司2011年底在业内首先提出液冷技术路线,并启动相关技术研究,于2015年率先推出国内首款量产的冷板式液冷解决方案,并于2019年在全球范围内首次实现了基于全浸式液体相变冷却技术解决方案的应用落地,是国内唯一实现浸没相变液冷技术大规模商业化部署的企业。聚焦液冷产品,配套服务完善。公司主要产品包括:液冷数据中心基础设施产品,包括浸没相变液冷数据中心基础设施产品-C8000系列和冷板液冷数据中心基础设施产品-C7000系列;风冷数据中心基础设施产品;液冷服务器套件产品;以及围绕上述产品提供系统集成和技术服务。浸没式贡献主要营收,冷板式营收占比逐年上升。分产品来看,2023年浸没相变液冷数据中心基础设施产品实现营收3.78亿元,占比58.15%。冷板液冷数据中心基础设施产品实现营收1.90亿元,占比为29.22%。其他产品和服务主要包括模块化数据中心产品,实现营收0.70亿元,占比为10.72%。配套产品实现营收0.07亿元,占比1.09%。技术和运维服务实现营收0.05亿元,2023年收入占比为0.81%。

08

市场空间

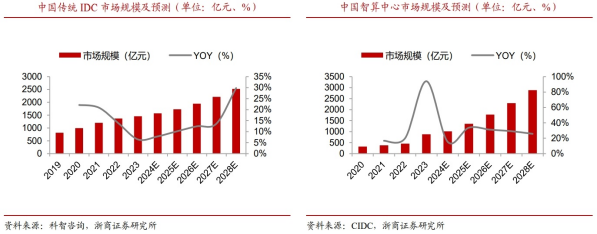

中国传统IDC业务将逐步回暖,市场有望迎来新一轮快速增长。2024年中国传统IDC市场规模约为1570亿元,CIDC预计2025-2028年市场规模从1730亿元增长至2525亿元,CAGR达到13%,近年来中国传统IDC业务规模增速有所放缓,但在政策及长期需求的驱动下,市场仍具有巨大潜力。未来随着宏观经济的稳步复苏、数字经济的持续发展,以及AI技术更新迭代并与各行业融合加速,中国传统IDC市场将迎来新的增长契机。

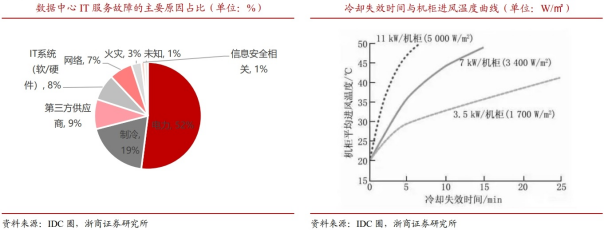

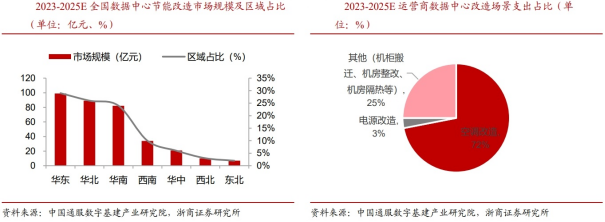

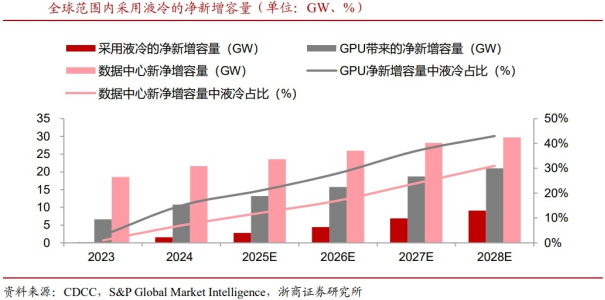

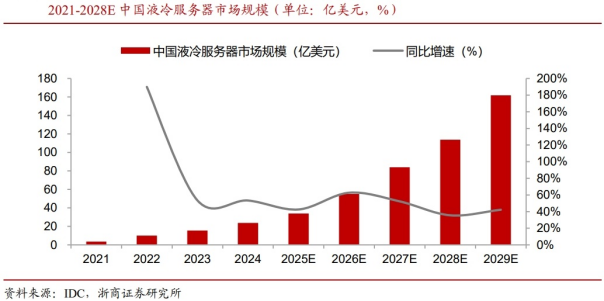

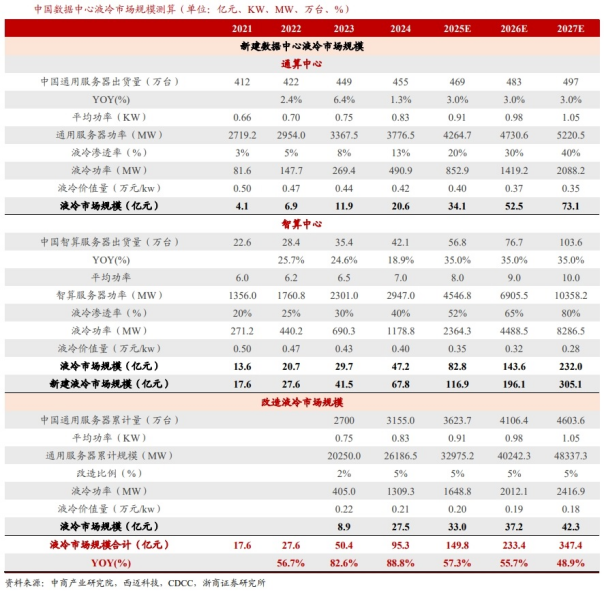

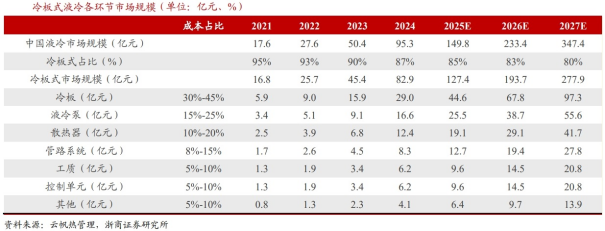

中国智算中心市场在需求推动下投资规模高速增长。2022年生成式人工智能大模型推向市场,2023年起国内头部互联网企业及科技公司加速AIGC布局,政府也牵头建设公共智能算力中心,赋能社会数字化转型需求,智算中心市场规模大幅增长。2024年中国智算中心市场规模约为1014亿元,预计2025-2028年市场规模从1356亿元增长至2886亿元,CAGR达到29%,未来,A工大模型应用场景不断丰富,智算中心市场增长动力逐渐由训练切换至推理,市场进入平稳增长期。制冷成数据中心故障主要原因之一,随着功率提升,服务器热保护关机时间显著缩短。据权威机构Uptime Institute研究表明,近些年制冷系统故障率已超过IT系统,成为供电、网络故障之后的最大数据中心宕机原因。一旦出现制冷故障,服务器温度会在几分钟内飙升到无法正常运转的程度。据《数据中心在制冷系统中断期间的温升》白皮书显示,机房制冷中断后只需要5分钟左右,“所有位置的温度都达到不可接受的温度范围”。随着IT负载的提升,高功率、高密度机柜在制冷中断情况下可稳定运行的时间也在缩减。据IDC圈数据,传统的3KW机柜在失去制冷后,服务器热保护关机时间大概有480s,4KW机柜则缩短到300s。当机柜密度达到8KW,热保护关机时间则缩减到不到240s,只有3KW机柜的一半。三大电信运营商合力发布液冷三年愿景,实现2025年50%以上液冷规模应用。全力打造高水平液冷生态链,构筑开放生态,推进液冷机柜与服务器解耦,引领形成统一标准,降低PUE(数据中心电能利用效率),获取最低TCO(全生命周期成本);发挥规模优势,大力拓展应用。冷板式液冷方面,推进形成拥有原创技术、接口标准统一、产业生态完善、应用规模最大的发展态势;浸没式液冷方面,推进形成标准统一化、产品国产化、实施工程化、推广规模化的发展格局。2023年开展技术验证,充分验证液冷技术性能,降低PUE,储备规划、建设与维护等技术能力;2024年开展规模测试,推进液冷机柜与服务器解耦,促进竞争,推进产业生态成熟,降低全生命周期成本;至2025年,开展规模应用,共同推进形成标准统一、生态完善、成本最优、规模应用的高质量发展格局,电信行业力争成为液冷技术的引领者、产业链的领航者、推广应用的领先者。多省份能效要求不断提升,液冷技术加速普及。中国通服数字基建产业研究院预计2025年,全国数据中心用电量达到1200亿度,全国数据中心的二氧化碳排放总量预计将达到10000万吨,约占全国排放总量的0.93%。节能优化和能源替换是两大减排途径,根据CDCC统计分析,2021年度全国数据中心平均PUE为1.49,其中华北、华东的数据中心平均PUE接近1.40,处于相对较优水平。华中、华南地区受地理位置、上架率及其他多种因素的影响,数据中心平均PUE值接近1.6,存在较大的提升空间。“东数西算”政策明确要求到2025年,东部枢纽节点数据中心PUE<1.25,西部枢纽节点数据中心PUE<1.2,实际上目前很多省份数据中心项目可研审批均要求在设计PUE在1.2以下,按照赛迪顾问相关数据测算,液冷渗透率预计在2025年达到20%。存量市场节能改造需求兴起,运营商数据中心改造场景中空调改造占比达72%。数据中心增量需求成倍增长的同时,存量市场节能改造需求也逐渐兴起,2023-2025年数据中心节能改造市场空间规模超340亿元,主要面向华东、华北、华南、西南等区域,节能改造市场规模分别为99亿元、89亿元、82亿元、34亿元,市场规模占比分别为29%、26%、24%、10%。改造需求主要来自运营商、第三方IDC服务商、金融等主体,其中运营商改造场景主要为空调、电源、机柜搬迁、机房整改等方向,其中空调改造规模占比最大,达72%。AI推动GPU功率提升,液冷成为制冷必然选择。据CDCC报道,由于新增GPU功率快速提升,制冷成为严重挑战,液冷成为必然的选择,根据大厂采用H100或以上类型GPU、非H100类型GPU、挖矿和企业应用等场景,综合来看,2025年和2028年全球范围内采用液冷的数据中心净新增容量预计为2.82GW和9.10GW,CAGR为47.78%,渗透率从2025年的12%快速提升至31%。数据中心转型液冷,预计2025-2029年中国液冷服务器市场CAGR达到47.8%。算力需求高速增长催化数据中心加速建设运行,在算力需求高增和数据中心承载能力有限的背景下,单机柜功耗有持续提升趋势,单机发热量提升带来的效率降低和故障率提升,催生出更强的温控需求,液冷技术相比风冷可有效节能且具备更高安全性,有望持续提升市占率。根据IDC数据,2025全年中国液冷服务器市场规模将达到33.9亿美元,与2024年相比增长42.6%。IDC预计,2025-2029年,中国液冷服务器市场年复合增长率将达到约48%,2028年市场规模将达到约162亿美元。液冷市场空间广阔,25-27年CAGR有望达到52.3%。目前液冷增长驱动主要为通算中心和智算中心的新建需求,以及存量通算中心改造需求。新建部分:根据中商产业研究院数据,2023年中国通用服务器出货量为449万台,智算服务器出货量则为35.4万台,考虑到通算中心平均功率较低,液冷渗透率较低,智算中心功率较高,渗透率较高,预测2025-2027年新建部分液冷市场规模从116.9亿元增长至305.1亿元,CAGR为61.6%。改造部分:根据国家数据局口径测算,2023年中国数据中心服务器约为2700万台,其中绝大部分PUE值较高,存在改造需求,预测2025-2027年改造部分液冷市场规模从33.0亿元增长至42.3亿元,CAGR为13.3%。总体来看,2025-2027年,预测中国液冷市场规模从149.8亿元增长至347.4亿元,CAGR为52.3%。冷板式液冷占比较大,冷板、液冷泵价值量占比较高。进一步来看,冷板式液冷目前占据液冷市场主流,预测2025-2027年其市场规模从127.4亿元增长至277.9亿元,CAGR为47.7%,其核心零部件2027年市场规模预测如下:冷板97.3亿元,液冷泵55.6亿元,散热器41.7亿元,管路系统27.8亿元,工质20.8亿元,控制单元20.8亿元。

09

参考研报

1.国金证券-液冷行业深度:智算需求驱动冷却技术升级,液冷生态迎成长契机—AIDC系列深度(二)

2.东莞证券-计算机行业液冷专题报告:从台商脉络探产业发展系列报告四

3.民生证券-AI液冷行业深度报告:液冷进入新纪元

4.东北证券-通信行业:UQD液冷遗珠,液冷零部件出海先行者

5.民生证券-通信行业深度:百亿液冷星辰大海,海内外同频共振

6.浙商证券-AI行业深度报告系列(一):液冷,AI算力时代,液冷需求爆发

7.东北证券-英维克-002837-精密温控龙头厂商,AI浪潮下业绩高速增长

VIP复盘网

VIP复盘网