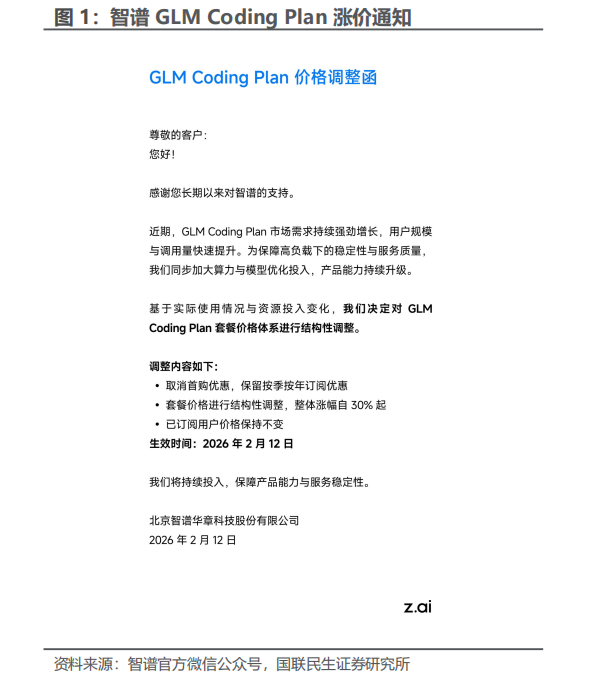

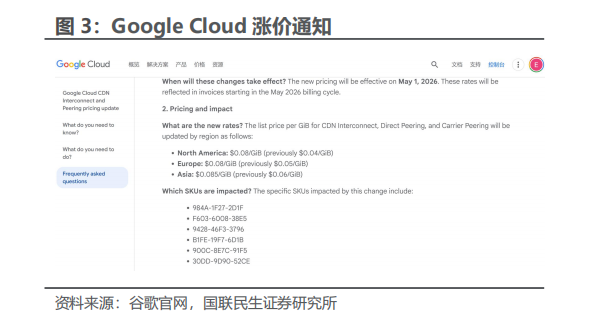

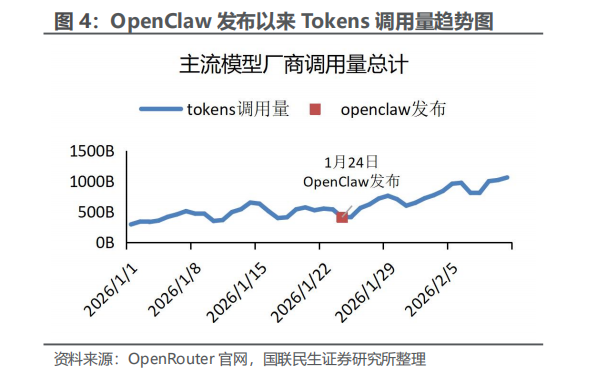

事件:2月12日,智谱在官方渠道宣布上调GLM Coding Plan订阅价格,涨幅“至少30%”。 此前,海外云厂商于本月纷纷提价,如Google Cloud在北美涨价幅度达100%,在欧洲与亚洲也同步上调;同时AWS的价格也上调了约15%。综合来看,Token需求“通胀”不仅利好云端算力,也让模型厂商拥有了议价权。

颠覆传统互联网的免费路径:传统互联网软件的典型路径是先用免费换用户规模,凭借“用户数和时长”换议价权,然后在广告、会员订阅、增值服务、交易抽佣里变现,免费背后的底层原因无非是边际成本极低。即多一个用户或多一次点击,成本却可以被带宽与存储规模效应稀释,从而达到近似为零的边际成本。

云计算时代也出现过类似的“先免费/低价再扩张”,但云的计费单位很快变成 CPU/存储/带宽/请求数,客户也习惯了“按量计费”。云能收费,是因为它交付的是明确的资源和SLA(服务提供商与客户签订的服务等级协议)。但当行业依旧处在“模型价格战”时,智谱却出现了涨价的信号,这意味着大模型时代的“计量单位”从流量(DAU/时长)转向Token(推理消耗),而Token的消耗在越来越多场景里是刚需。

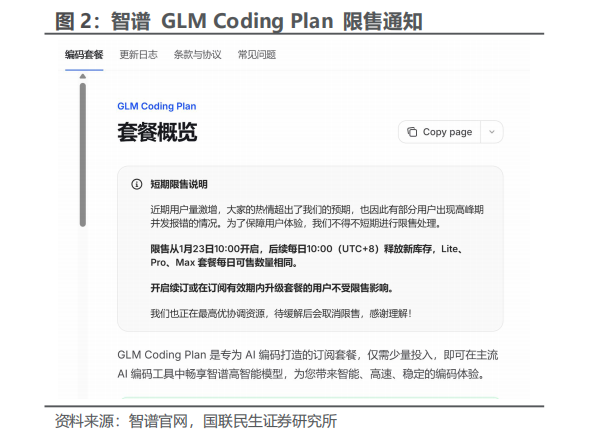

大模型时代的变化:Token变成“可计量的生产资料”,不再是“免费流量”。大模型把“对话/写代码/生成内容”这类看似是由软件供应商提供的服务,变成了强依赖算力的在线推理服务。对模型厂商而言,每一次回答都要实打实地消耗GPU、显存、带宽与电力;对用户来说,每一次“让模型多想一会儿、写一段更长的代码、跑一个更复杂的任务”都对应更多Token的消耗,于是Token天然成为新的计量单位。智谱此前正因为用户增长导致算力阶段性紧张,对Coding Plan做过“限量发售”安排,这与其后续涨价形成了一个非常典型的“供需链条”:需求在短期内大幅增长→资源呈现刚性约束(导致限流/限量)→涨价。

当高峰期拥堵与资源紧张出现时,涨价是一种让模型厂筛选需求的机制,比“无差别限流”更能保护用户的体验。并且,模型厂商的成本端仍与GPU供给、利用率、推理优化强相关,涨价/更合理的分层定价能把模型厂商从“规模越大亏得越多”的陷阱里拉出来,有利于提升毛利与现金流质量。

Token需求在“通胀”:“Token通胀”,不是指Token本身变贵,而是指单位时间内、单位用户的Token消耗结构性上升。Token需求的高涨有以下几个原因:

从“问答”变为“干活”:模型发展至今,用户不再满足于简单的回答形式,而是开始让模型重构代码、改写文件、生成文档和跑测试等等。编程场景的特征天然是“长上下文、多轮迭代、大量输出”,这对Token是大量的消耗。通过智谱的表述,也证实了开发者依靠其模型用于编码支持,导致Token消耗的快速增长。

从“单轮”到“Agent的多轮”:智谱把GLM-5定位为面向Coding与Agent场景的新一代模型;2月12日,MiniMax也把正式上线的最新旗舰编程模型M2.5标注为全球首个为Agent场景原生设计的生产级模型。将M2.5的编程与智能体性能(Coding&Agentic)直接对标Claude Opus4.6。Agent会主动规划、检索、执行、反思,多次调用模型,Token消耗自然按步骤累加。

推理强度上升:更多“深度思考、更长链路推理”会显著提高输出与中间过程的Token消耗。对开发者而言,这往往带来更高成功率与更少返工,用户反而愿意“多烧Token换效率”。

这意味着Token不是传统互联网时代边际成本几乎为零的“流量”,而是生产任务时必不可少的“燃料”。

投资建议:云计算逐步变为“卖资源”,而大模型厂商化身“卖Token燃料 卖成果”。智谱GLM Coding Plan的涨价折射的是产业定价逻辑的改变:当推理消耗变成生产资料,模型厂商有机会把“算力稀缺”通过分层定价与订阅化产品转化为毛利与现金流。建议后续持续关注:

云厂商与算力基础设施:AI拉动的IT支出与基础设施投入仍处上行周期,云侧将受益于GPU算力、存储与网络I/O等“伴随型消耗”的持续增长。

大模型厂商:当它们能在编程、Agent、企业流程等高ROI场景中维持订阅留存与企业席位扩张,能把“Token用量”稳定转成“省人省时省返工”的交付价值时,就具备了穿越开源与价格战的能力。

安全治理与运行时的防护工具:随着企业把AI嵌入工作流,数据泄露、代理越权等风险将推动“AI安全平台/治理平台”成为刚需层。

短期观察提价与需求(Token“通胀”)带来的边际改善,中期跟踪企业席位与订阅留存带来的续费与扩张,长期看好治理工具普及带来的“AI防火墙”新增市场。

VIP复盘网

VIP复盘网