编者按:从智能终端到人工智能终端的跃升可谓是智能化终端的“二次革命”,从底层硬件到操作系统,从应用框架到交互方式,都将发生天翻地覆的变化,整个终端及上下游产业也随时巨变。为推动人工智能终端产品普及,促进产业健康有序发展,《中国电子报》联手人工智能终端工作组推出“AI时代终端大变局”系列报道,将从产品之变、场景之变、技术之变、生态之变等角度探讨产业变化,并开设“大家谈”纸面圆桌论坛,凝聚业界智慧、共商产业大计。

AI时代,一款消费级智能终端在不联网的情况下能有多大能耐?智能终端只靠端侧模型能发挥多大的作用?过去一年,业界关于这个问题讨论的风向正在悄然发生变化——“能跑在端侧就跑在端侧”的声音越来越小,“云边端协同”的声音越来越大。

在“云边端协同”逐渐成为行业共识的背景下,到底哪些任务要放在端侧,什么才是端侧模型的终极目标?

端侧运行AI是“不得不”么?

刨除用户对隐私安全的顾虑,单纯从模型可调用的算力资源上限来看,用户日常需求,云端大模型都能满足,但为什么仍要强调终端设备的端侧模型处理能力?

“省钱”是驱动终端厂商提升端侧算力的重要动力。

在一次行业活动上,国内某芯片行业专家表示,手机上有很多功能利用了AI计算能力,诸如翻译、图片消除等,这些功能目前都是免费提供。而如果这些功能调用的都是云端资源,每年使用这些功能所耗费的AI服务资源,一年将相当于一台手机的成本。

基于这样的原因,终端厂商急于将更多的应用运行在端侧,在提升产品性能的同时降低调用云端算力的成本。

智能手机的听写功能

什么样的任务必须在端侧运行?

针对这一问题,一位AI开发者在接受记者采访时总结了三个条件:其一,便宜,可以直接调用本地算力;其二,任务具有实时性要求,不能受到网络延迟影响;其三,数据对安全隐私要求高。

“如果业务存在这三方面需求,就必须在端侧运行。”这位开发者说,“如果不存在上述三方面的需求,则可以从价格等方面评估,寻求能够实现最高ROI的部署方案。”

端侧设备AI支撑能力面临收敛?

模型要运行在端侧,“小”是首要条件。端侧模型的运行受限于设备的内存容量。主流消费级电脑内存容量在16~32GB,能够运行量化后约为7B~13B参数的模型;配备32GB RAM 12GB显存的高性能台式机,能够运行约20B参数量化模型。在内存容量更低的手机上,可运行的模型规模就更有限。具备12GB~16GB内存的旗舰机型,能够运行7B模型。

从市场反馈来看,已经有厂商选择收敛端侧设备的AI支撑能力。

1月15日,联发科举行新品发布会,发布两款次旗舰级芯片——天玑8500、天玑 9500s,主要应用于非旗舰款的大众机型。在这次发布会上,芯片厂商将其芯片的AI相关能力集中在实况照片美化,AI照片编辑(扩图、抠图、消除)、AI内容摘要等日常高频场景中。发布会后,业内芯片专家分析称,之所以这样设计,是为了将AI技术生活化。对于手机这样体量的设备而言,装配太大的模型是不现实的。端侧AI应该与操作系统做结合,使AI赋能用户生活的过程更丝滑。

PC产品端同样存在端侧设备计算资源受限的情况,但从产业界的实践来看,软硬件开发者们的创新实践正不断拉高端侧设备的功能上限。

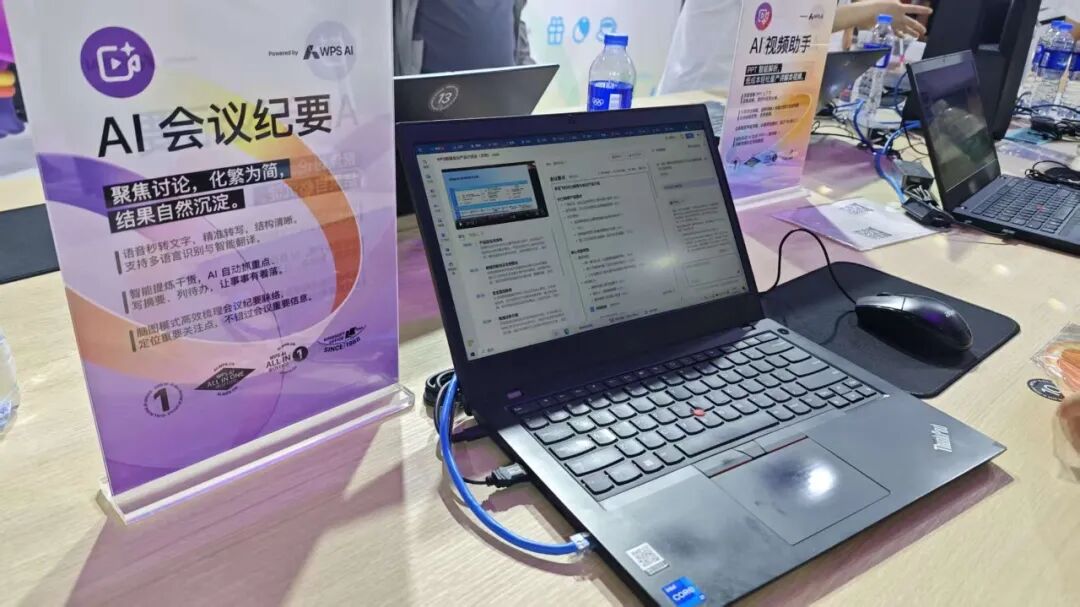

PC设备上的AI会议纪要功能展示

星环无涯研发经理龚存阳表示:“端侧模型的部署通常受限于计算资源,端侧模型的能力上限主要取决于硬件配置与参数规模。因此往往采用混合专家模型(MoE)架构并结合量化技术以实现模型的轻量化。”

不仅如此,快速迭代的模型产品也在端侧设备有限的算力基础上不断提升功能上限。龚存阳称,在高配置的PC上,本地运行30B参数级别的模型已能胜任复杂的推理任务。以近期热门的AI Agent Clawdbot为例,传统AI Agent多依赖云端大模型,而“无涯问知AIPC”通过搭载本地30B大模型并结合Clawdbot,可通过即时通讯软件,以自然语言交互的方式指挥笔记本执行联网搜索及本地问答。

智能终端如何成就AI Agent?

“更懂用户”正不约而同地成为几乎所有智能终端的设计目标。

面对“千人千面”的用户群体,在处理复杂任务时,终端设备何以实现用户“一句指令”,设备自行运转?

对于AI Agent的需求,即便是端侧算力较高的PC类产品,想要实现全流程AI任务实现,也颇有难度。

对此,业界专家表示,从技术实现方式来理解,让端侧模型更懂用户是AI的短期记忆和长期记忆如何搭配的问题。所谓短期记忆,指的是在用户与模型对话的时候,模型能够把前几轮的对话内容代入下一轮对话中,结合过往问答信息给出回答。而长期记忆,指的是将参数特征写入RAG库,通过RAG在下次问答时搜索用户的个人专属信息及特征,再通过模型给出贴切的答案。

要实现这样的效果,对于端侧模型和设备有两大要求:其一,模型要足够聪明或能够涵盖所涉及的领域,适当参数量的专属模型或至少7B参数量的通用模型才能处理这样的任务;其二,本地算力要够高,模型要处理的上下文越长,所需的本地算力就越高,有条件的话可以通过AI专属加速硬件来提升处理速度。

VIP复盘网

VIP复盘网