摘要

行业观点:

相关标的:

风险提示

行业竞争加剧的风险;技术研发进度不及预期的风险;特定行业下游资本开支周期性波动的风险。

报告正文:

01 Agent生态持续扩张

近期全球Agent生态进展不断,业界创新频出:

AI助手Clawdbot爆火,展现Agent新形态。第一财经1月29日报道,近期一款名为Clawdbot 的 AI助手近期从海外火到国内,成为2026年开年最受瞩目的AI爆款。它不仅吸引大量开发者尝试,更引来腾讯云、阿里云等国内云厂商火速接入,提供一键部署服务。通俗来说,Clawdbot 如同一个线上版“贾维斯”,能接管个人终端几乎所有任务。作为一个免费开源项目,它迅速吸引了大量开发者与从业者参与测试并分享体验。Clawdbot可以帮用户清空收件箱、发送电子邮件、管理日历、办理航班值机等等,并且可以接入用户常用的任何聊天APP,所有的操作均可通过 WhatsApp、Telegram等平台完成,用户只需通过对话,就能操控设备自动执行各类任务。Clawdbot甚至带火了苹果Mac mini,有不少人为了让Clawdbot 24 小时在线运行,专门去下单了一台,谷歌AI产品负责人Logan Kilpatrick就是其中之一。Clawdbot 的核心设计理念是“本地运行”,它能深度访问用户的电脑系统、文件、应用和聊天记录,因此,将它部署在独立的Mac mini 上,可以避免与主力工作电脑混用,最大程度保障隐私和系统安全。目前Clawdbot 更像是少数极客的尝鲜项目。然而它所带来的“贾维斯”式的未来人机交互体验,为行业打开一扇新的窗口。

02 三大逻辑揭示Agent对CPU的刚性需求

02 三大逻辑揭示Agent对CPU的刚性需求

随着大模型的应用从简单的Chatbot向能完成复杂任务的Agent演进,计算负载的重心正在发生微妙的偏移。Agent不仅需要GPU进行模型推理,更依赖高性能CPU来处理复杂的逻辑编排、工具调用和内存管理。以下是我们认为Agent驱动 CPU 需求爆发的三大核心逻辑:

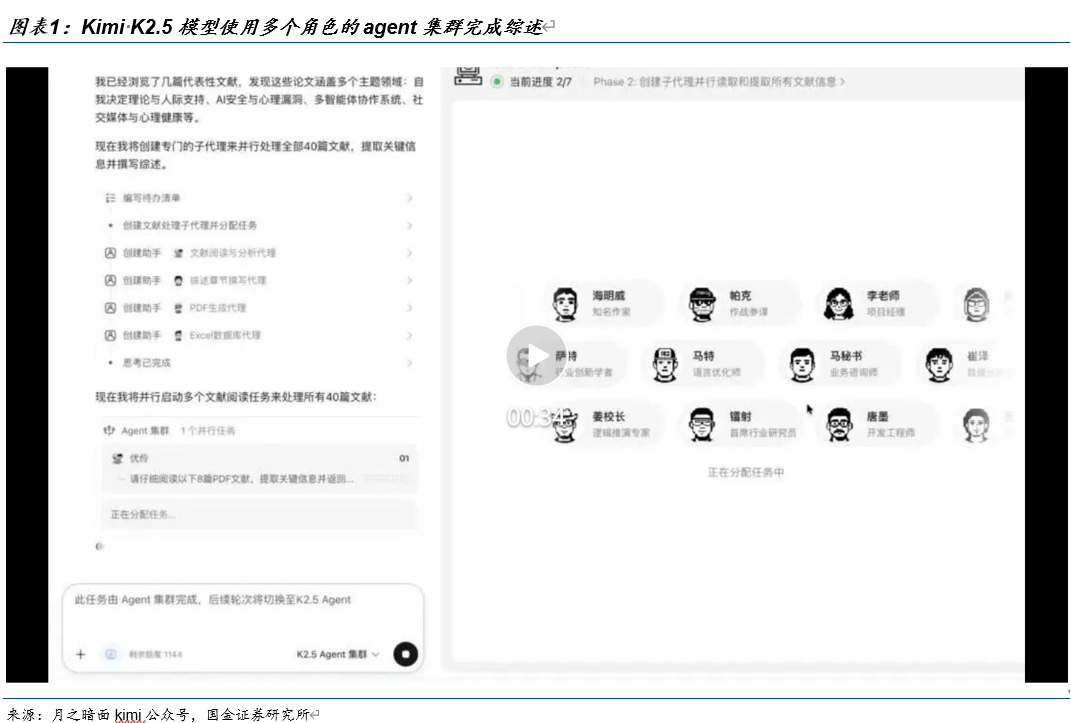

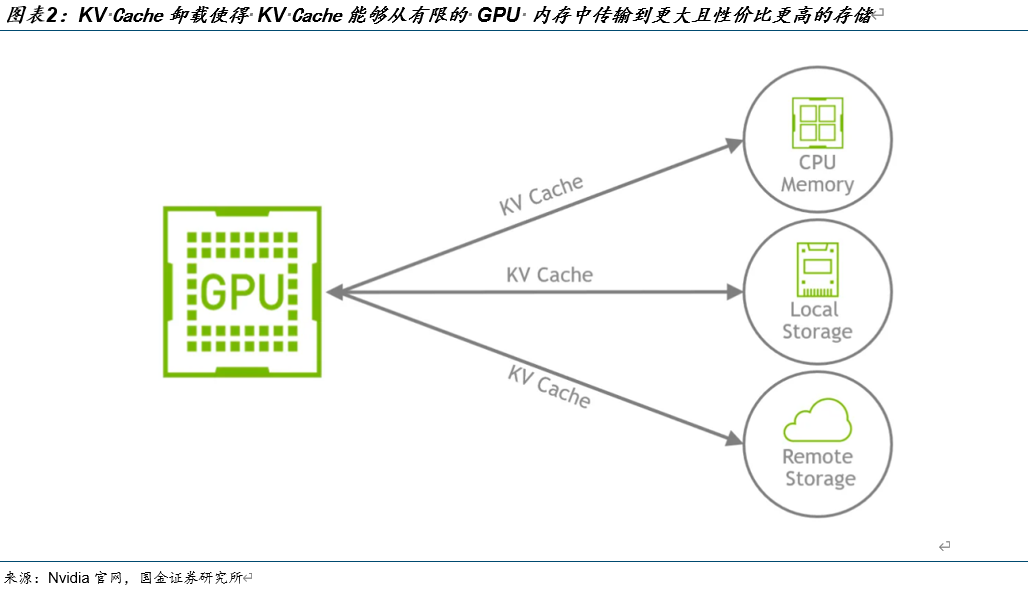

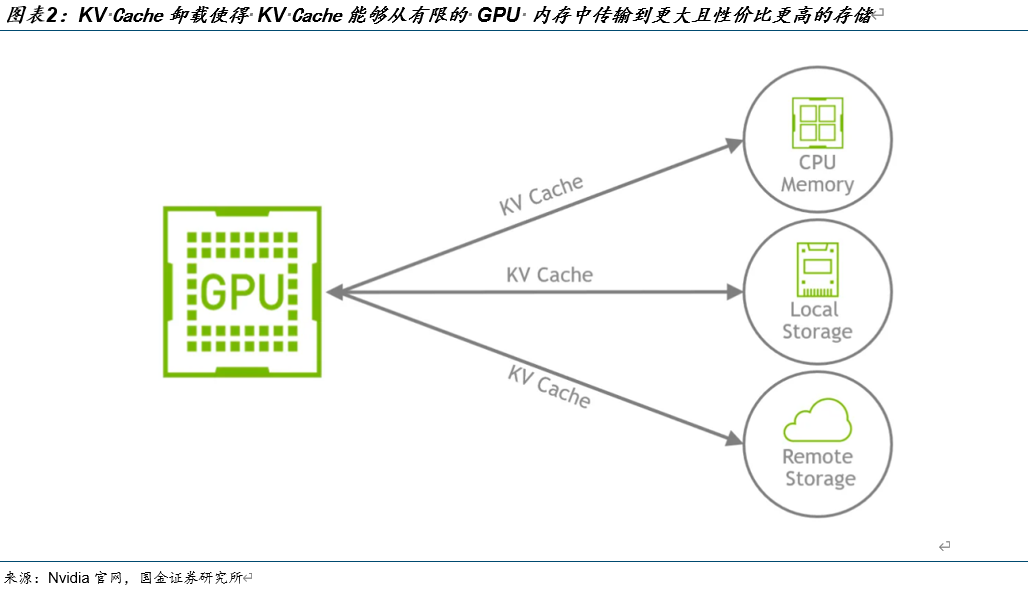

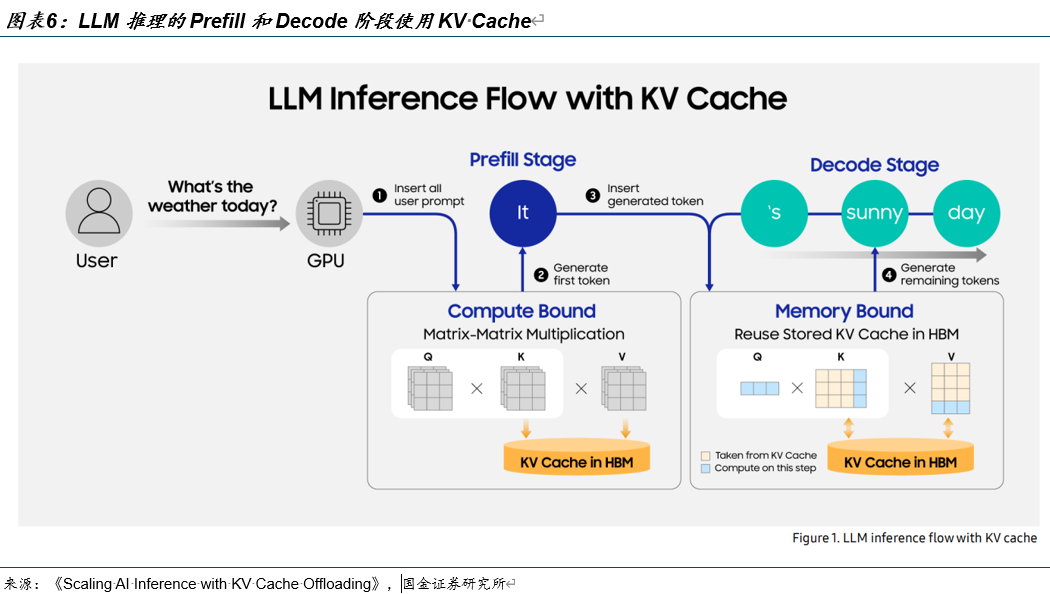

①Multi-Agent 架构引发的OS调度压力 传统的 LLM 对话是线性的,而 Agent 的工作流则是复杂的闭环。“推理→执行→评估→反思”的循环机制: Agent 需要在生成 Token 之外,执行大量的逻辑判断和状态管理。,模型需要不断在“思考”和“行动”之间切换。导致操作系统层面的上下文切换和进程调度任务大幅增加。 沙盒(Sandbox)需求飙升: Agent 执行代码等操作经常需要在隔离的云端沙盒中运行。这些沙盒环境的启动、运行和销毁依赖 CPU 算力。 ②长上下文场景下的 KV Cache 卸载对CPU的挑战 naddod的技术文章阐述了其原理,键值缓存 (KV Cache) 可以加速 Transformer 推理,但它也会带来一个副作用:消耗大量显存。随着大型语言模型上下文长度的不断增长,这个问题会变得越来越突出。例如当上下文长度达到 8 万个token时,仅 KV Cache 本身就可能消耗数十 GB 的显存。更重要的是,GPU 显存不仅要容纳 KV Cache,还要容纳模型权重和中间计算结果。一旦显存耗尽,推理就会崩溃甚至失败。为了解决这一冲突,业界提出了键值缓存卸载(KV Cache Offload)方案。其核心思想是将GPU内存中不活跃或暂时未使用的键值数据迁移到其他存储介质例如CPU内存或者SSD。然而CPU 与 GPU 之间的通信带宽远低于 GPU 内部的 HBM 带宽。而且在进行 KV Cache 传输和管理时,也需要 CPU 进行任务的调度,进一步加剧了 CPU 的负载。 NVIDIA 2025年9月的一篇技术博客《How to Reduce KV Cache Bottlenecks with NVIDIA Dynamo》就专门阐述了在长上下文场景下,利用 NVIDIA Dynamo 等技术将 KV Cache 卸载到 CPU内存的必要性,并指出这是解决 HBM 瓶颈的关键手段。

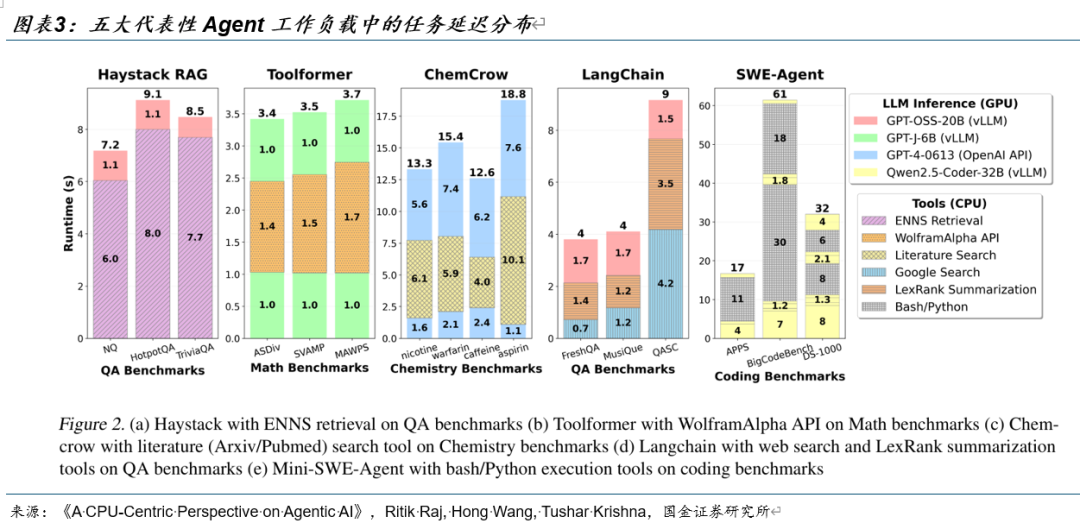

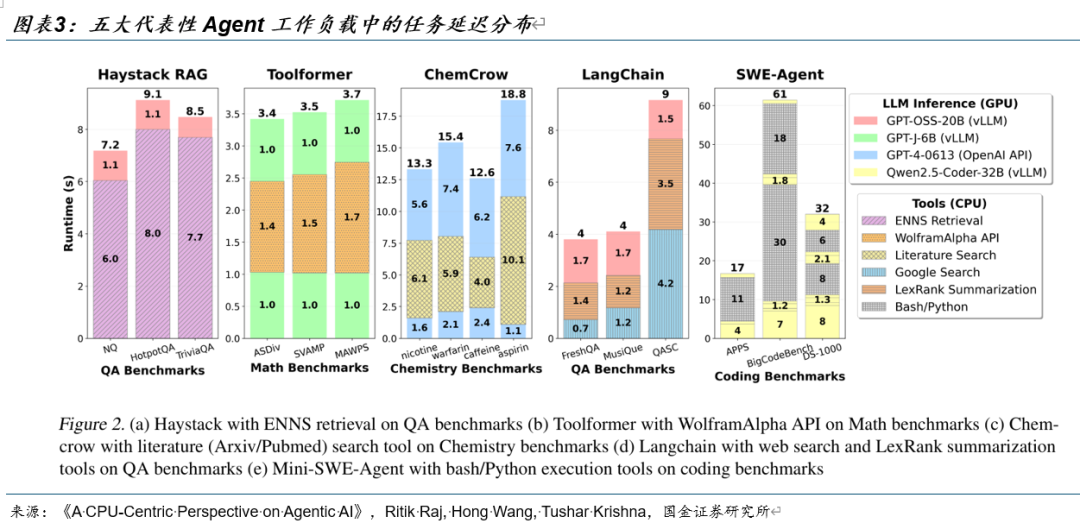

Agent 的能力不仅在于对话,更在于使用工具,例如检索、写代码、浏览网页。这些非模型推理任务主要由 CPU 承担。前文五大代表性Agent工作负载中各项任务的延迟数据证明了这一点。而且在高并发场景下可能有大量Agent 同时工作,这些任务需要高性能 CPU 进行多线程/多进程处理。

据英特尔与佐治亚理工学院2025 年11月的论文《A CPU-CENTRIC PERSPECTIVE ON AGENTIC AI》对代表性Agent任务进行了延迟、吞吐量和能耗指标的分析,揭示CPU相对于GPU对这些指标的显著影响,结果表明很多情况下GPU是Agent性能的瓶颈:在五大代表性Agent工作负载(HaystackRAG、Toolformer、ChemCrow、LangChain、SWE-Agent)中,.CPU.端的工具处理占延迟的.43.8%~90.6%.(如.ENNS.检索、WolframAlphaAPl.调用、文献搜索).,而.LLM.推理仅占较小部分。如HaystackRAG在.Natural.Questions.基准测试中检索耗时.8.0.秒(占总延迟.90.6%),LLM.推理仅0.5秒。

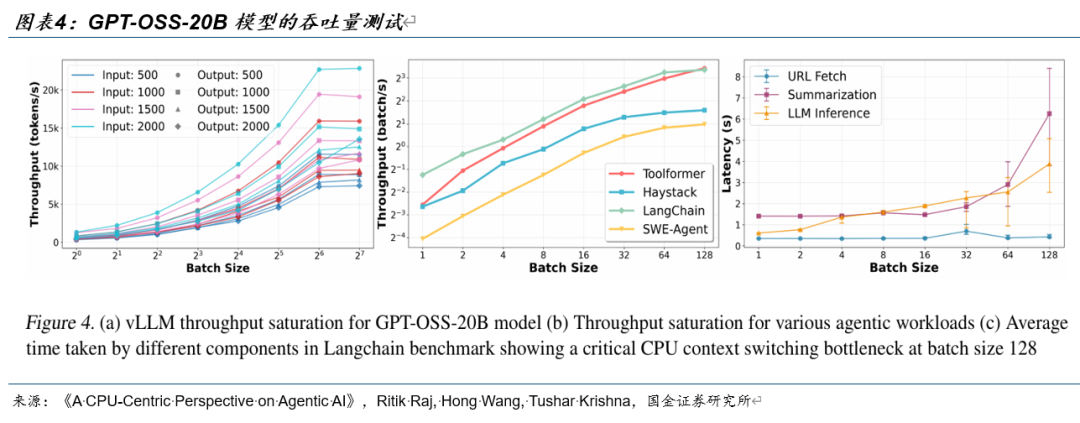

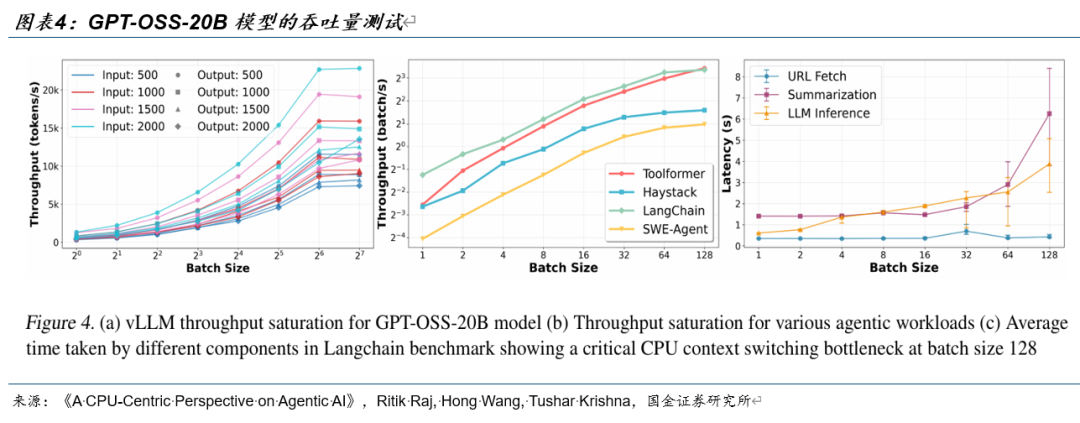

在GPT-OSS-20B模型的吞吐量测试中,随着 Batch Size 增加,不同 Agentic 工作负载的吞吐量增长逐渐放缓并趋于饱和:以 Langchain 为例,展示了当 Batch Size 达到 128 时,Langchain 基准测试中各组件的平均耗时(数据显示批次大小为 128 时存在严重的 CPU 上下文切换瓶颈)。

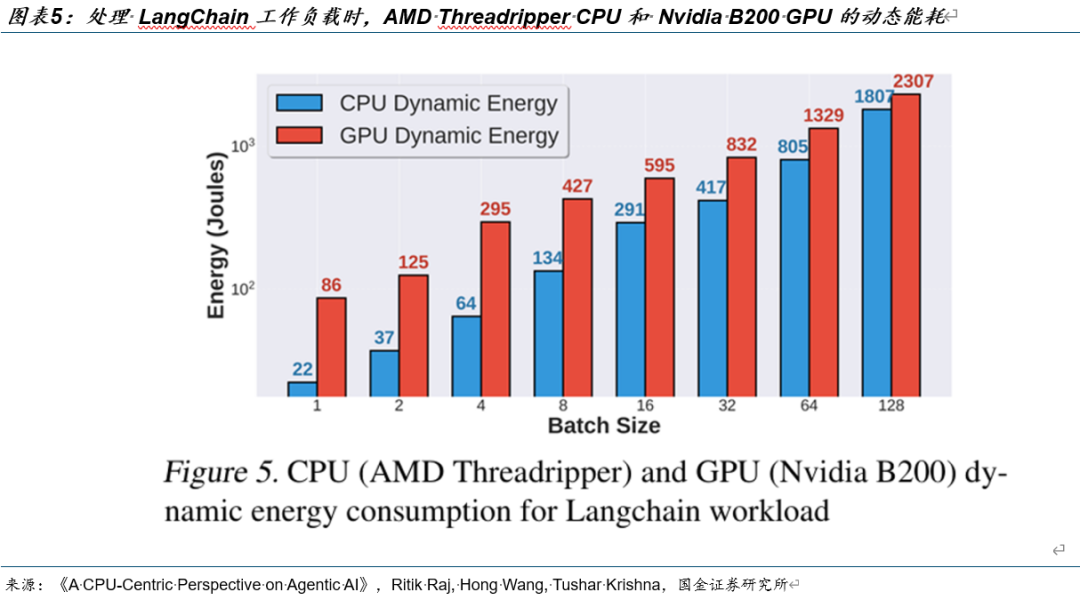

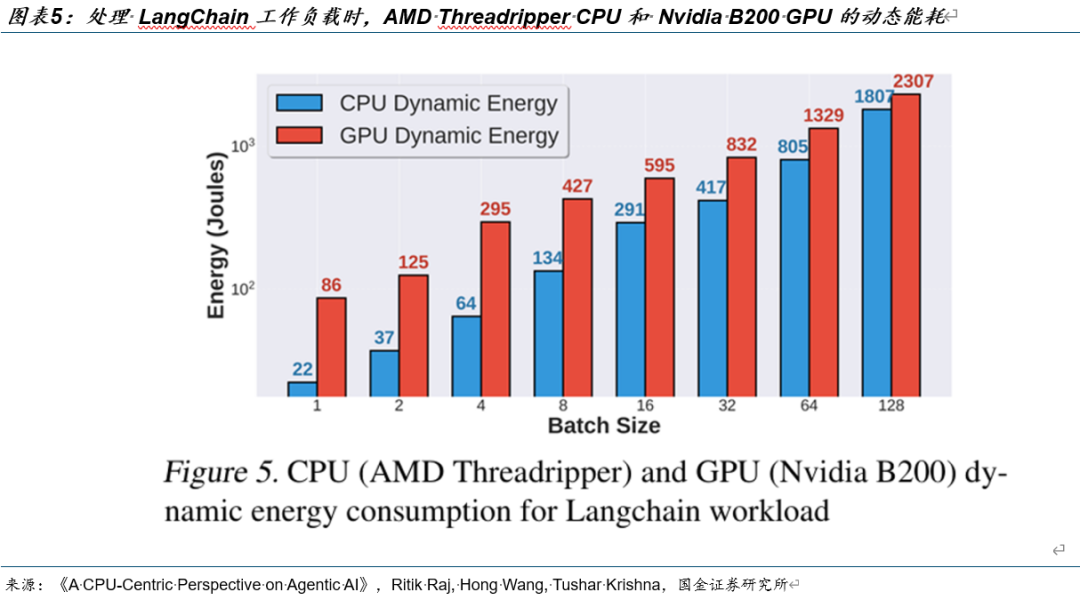

在处理 LangChain 工作负载时,AMD Threadripper CPU和 Nvidia B200 GPU的动态能耗。关键转折点:在低 Batch Size(如 1-4)时,GPU 能耗显著高于 CPU。但随着 Batch Size 增加到 128 时,CPU 的能耗(1807 Joules)已经非常接近 GPU(2307 Joules)

同时我们认为DeepSeek Engram架构或进一步推动以存代算。DeepSeek推出Engram架构,把大模型里的“计算”和“超大规模记忆”解耦,Transformer的算子全部在GPU/加速卡上计算,而1000亿参数的Engram表存储运行则在CPU内存中,仅产生可忽略的开销(小于 3%)。

此外,Anthropic也给Claude Cowork重磅升级,通过知识库为Claude设计的一种全新永久记忆方式。我们认为,类Engram架构能有效突破GPU显存限制,从而推动以存代算需求和CPU配比提升。

03 Agent驱动存储需求持续增长

Agent的执行过程需要记忆以及上下文缓存,对存储带来了巨大需求。

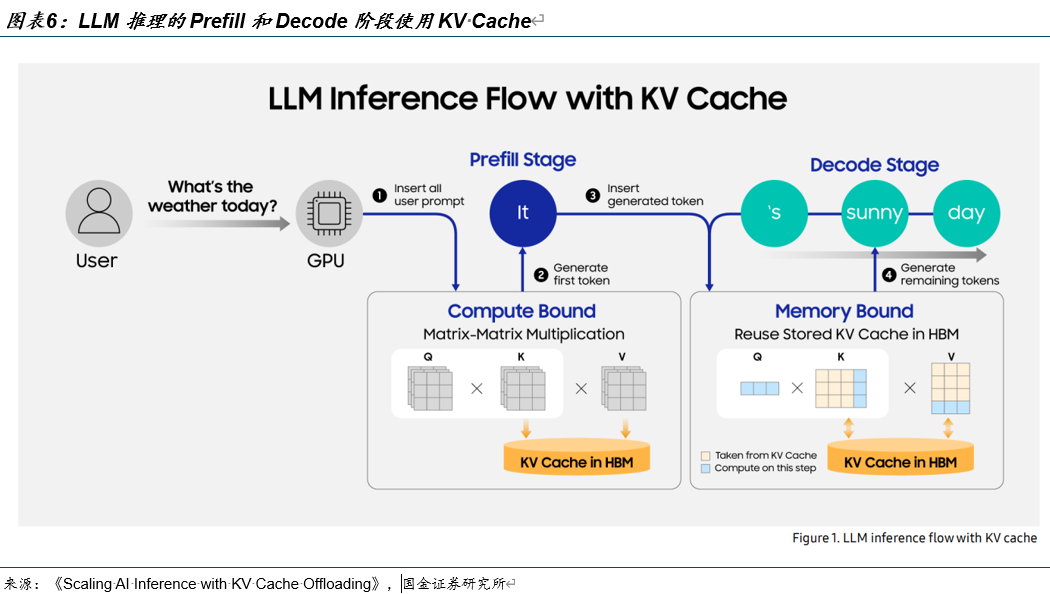

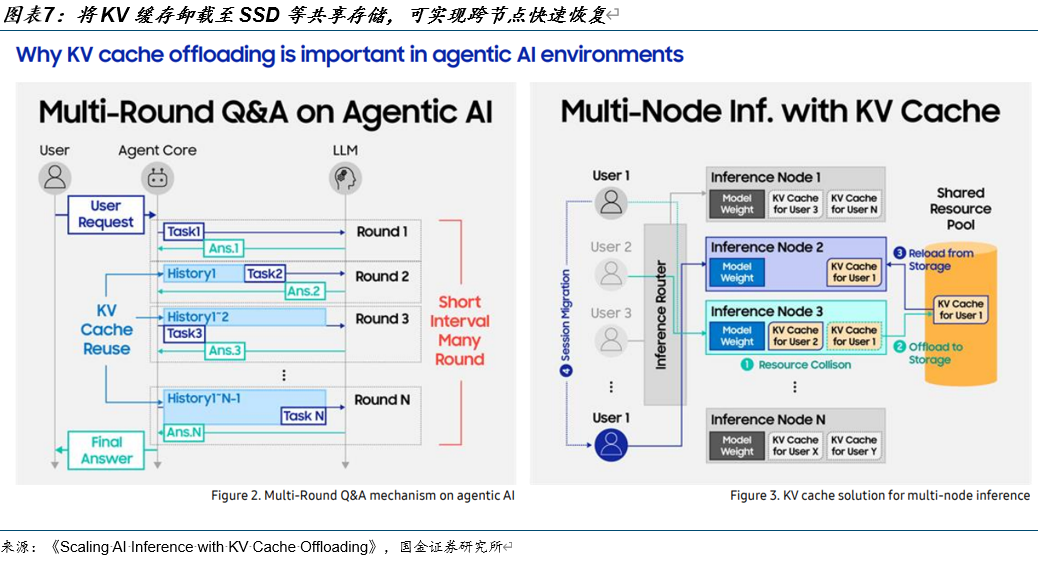

三星发布的白皮书《Scaling AI Inference with KV Cache Offloading》深入探讨了在大型语言模型(LLM)和“代理式 AI”(Agentic AI)时代,如何利用SSD进行 KV Cache Offloading,以解决GPU显存瓶颈、提高推理性能并降低成本。 LLM推理包含预填充(Prefill)和解码(Decode)两个阶段: Prefill阶段:一次性处理完整提示词,生成初始键值对(KV Cache),存储在GPU显存中,此阶段以计算为主。 Decode阶段:基于KV Cache逐 token 生成输出,以内存访问为主。 KV缓存通过复用已计算的键值对,避免重复计算,显著提升推理效率。

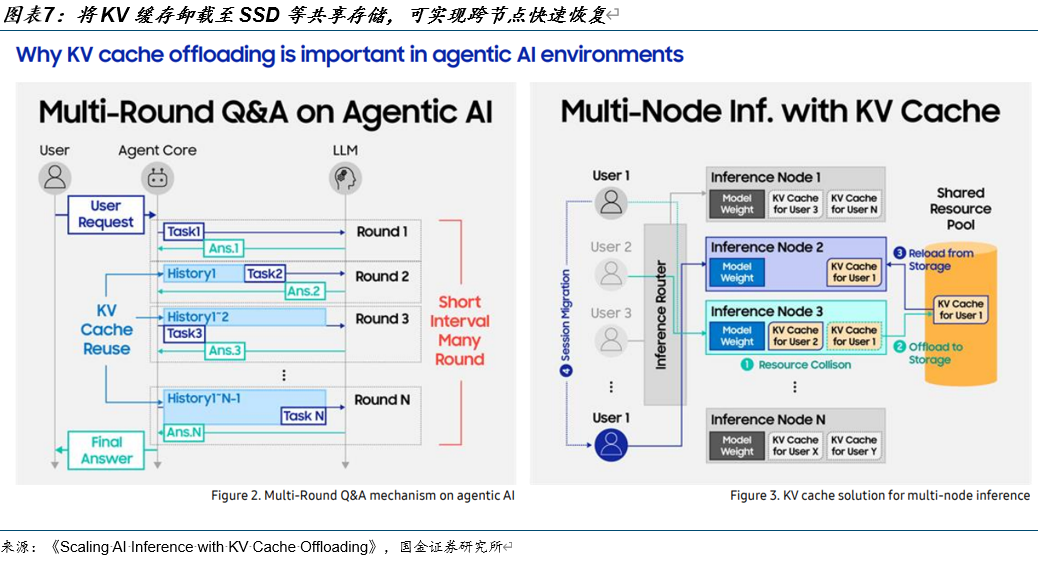

在Agent环境中,多轮对话需反复处理相似提示词。若KV缓存仅存于GPU本地,会话迁移时(如负载均衡)需重新预填充,引入高延迟。通过将KV缓存卸载至NVMe SSD等共享存储,可实现跨节点快速恢复。

近期美国存储厂商陆续披露亮眼业绩。 据科创板日报,在截至今年1月2日的财年第二财季期间,希捷营收同比增长22%至28.3亿美元,经调整每股净利润为3.11美元。分析师的事前一致预期分别为营收27.5亿美元,调整后EPS 2.83美元。更令市场鼓舞的是公司给出的指引。希捷表示,财年第三季度的调整后EPS预期在3.2至3.6美元,远高于分析师预期的2.99美元;同时销售额指引为28至30亿美元间,也完全高于分析师预期的27.9亿美元。希捷科技CEO在公司财报电话会议上表示,2026年的产能已经分配完毕,“我们预计将在未来几个月开始接受2027年上半年的订单。” 由于人工智能工作负载和数据中心建设的增加,存储需求激增。希捷CEO补充说智能体也将刺激存储需求:“Agentic AI依赖于对大量历史数据的持续访问,以实现有效的规划、推理和独立决策。其应用已呈现加速增长的趋势,一家领先的云服务提供商最近进行的一项调查显示,超过一半的受访客户正在积极使用人工智能代理。早期采用者已经获得了可衡量的回报,其收益涵盖了从降低成本到增加收入机会等各个方面。随着Agent部署在边缘端(那里往往蕴藏着大量未开发的数据),我们相信,这将为生成和存储的数据量持续且显著地增长奠定基础,从而支持推理、持续训练并维护模型的完整性。

当地时间1月29日闪迪公布2026财年第二财季业绩报告。第二财季公司营收为30.25亿美元,同比增长61%;GAAP口径下净利润为8.03亿美元,同比增长672%;GAAP口径下稀释后每股收益为5.15美元,同比增长615%;GAAP口径下毛利率为50.9%,相比去年同期提升18.6%,全面超越市场预期。”业绩指引方面,公司预计,2026财年第三财季营收将在44亿美元至48亿美元之间,GAAP毛利率预计在64.9%至66.9%之间。SanDisk首席执行官David Goeckeler表示,展望未来,2026年之后的客户需求远高于供应。在世界上一些最大和资本最雄厚的科技公司的推动下,预计数据中心将在2026年首次成为NAND的最大市场。公司称闪迪处于AI基础设施广泛扩张的中心,随着AI工作负载的扩展,企业级SSD需求在整个生态系统中加速增长,特别是推理推动了每次部署中NAND含量的显著增加

相关标的

海外算力/存储:中际旭创、新易盛、兆易创新、大普微、中微公司、天孚通信、源杰科技、胜宏科技、景旺电子、英维克等;闪迪、铠侠、美光、SK海力士、中微公司、北方华创、拓荆科技、长川科技。 国内算力:寒武纪、东阳光、海光信息、协创数据、华丰科技、星环科技、网宿科技、首都在线、神州数码、百度集团、大位科技、润建股份、中芯国际、华虹半导体、中科曙光、润泽科技、浪潮信息、东山精密、亿田智能、奥飞数据、云赛智联、瑞晟智能、科华数据、潍柴重机、金山云、欧陆通、杰创智能。 CPU:海光信息、中科曙光、澜起科技、禾盛新材、中国长城、龙芯中科、兴森科技、深南电路、宏和科技、广合科技。

风险提示

行业竞争加剧的风险:

在信创等政策持续加码支持计算机行业发展的背景下,众多新兴玩家参与到市场竞争之中,若市场竞争进一步加剧,竞争优势偏弱的企业或面临出清,某些中低端品类的毛利率或受到一定程度影响。

技术研发进度不及预期的风险:

计算机行业技术开发需投入大量资源,如果相关厂商新品研发进程不及预期,表观层面将呈现出投入产出在较长时期的滞后特征。

特定行业下游资本开支周期性波动的风险:

部分计算机公司系顺周期行业,下游资本开支波动与行业周期性相关性较强,或在个别年份对于上游软件厂商的营收表现产生扰动。

随着大模型的应用从简单的Chatbot向能完成复杂任务的Agent演进,计算负载的重心正在发生微妙的偏移。Agent不仅需要GPU进行模型推理,更依赖高性能CPU来处理复杂的逻辑编排、工具调用和内存管理。以下是我们认为Agent驱动 CPU 需求爆发的三大核心逻辑:

Agent 的能力不仅在于对话,更在于使用工具,例如检索、写代码、浏览网页。这些非模型推理任务主要由 CPU 承担。前文五大代表性Agent工作负载中各项任务的延迟数据证明了这一点。而且在高并发场景下可能有大量Agent 同时工作,这些任务需要高性能 CPU 进行多线程/多进程处理。

在GPT-OSS-20B模型的吞吐量测试中,随着 Batch Size 增加,不同 Agentic 工作负载的吞吐量增长逐渐放缓并趋于饱和:以 Langchain 为例,展示了当 Batch Size 达到 128 时,Langchain 基准测试中各组件的平均耗时(数据显示批次大小为 128 时存在严重的 CPU 上下文切换瓶颈)。

在处理 LangChain 工作负载时,AMD Threadripper CPU和 Nvidia B200 GPU的动态能耗。关键转折点:在低 Batch Size(如 1-4)时,GPU 能耗显著高于 CPU。但随着 Batch Size 增加到 128 时,CPU 的能耗(1807 Joules)已经非常接近 GPU(2307 Joules)

此外,Anthropic也给Claude Cowork重磅升级,通过知识库为Claude设计的一种全新永久记忆方式。我们认为,类Engram架构能有效突破GPU显存限制,从而推动以存代算需求和CPU配比提升。

03 Agent驱动存储需求持续增长

Agent的执行过程需要记忆以及上下文缓存,对存储带来了巨大需求。

相关标的

风险提示

行业竞争加剧的风险:

在信创等政策持续加码支持计算机行业发展的背景下,众多新兴玩家参与到市场竞争之中,若市场竞争进一步加剧,竞争优势偏弱的企业或面临出清,某些中低端品类的毛利率或受到一定程度影响。

技术研发进度不及预期的风险:

计算机行业技术开发需投入大量资源,如果相关厂商新品研发进程不及预期,表观层面将呈现出投入产出在较长时期的滞后特征。

特定行业下游资本开支周期性波动的风险:

部分计算机公司系顺周期行业,下游资本开支波动与行业周期性相关性较强,或在个别年份对于上游软件厂商的营收表现产生扰动。

VIP复盘网

VIP复盘网